Współczesna gospodarka cyfrowa opiera się na niewidzialnym, lecz fundamentalnym filarze: kryptografii klucza publicznego. Algorytmy takie jak RSA i ECC stały się synonimem cyfrowego zaufania, jednak ten fundament stoi w obliczu egzystencjalnego zagrożenia. Pojawienie się komputerów kwantowych zdolnych do złamania obecnych standardów szyfrowania nie jest kolejnym ewolucyjnym krokiem w cyberbezpieczeństwie; to rewolucja, która wymusza na liderach technologicznych fundamentalną zmianę myślenia o ochronie danych.

Zagrożenie kwantowe nie jest odległą, teoretyczną możliwością. Materializuje się już dziś poprzez strategię znaną jako „Harvest Now, Decrypt Later” (HNDL), czyli „Zbierz teraz, odszyfruj później”. Adwersarze, w tym podmioty państwowe, aktywnie przechwytują i magazynują ogromne ilości zaszyfrowanych danych, cierpliwie czekając na moment, w którym kryptograficznie relewantny komputer kwantowy (CRQC) stanie się operacyjny. W tym momencie dane, które dziś uważamy za bezpieczne, zostaną retrospektywnie złamane. To fundamentalnie zmienia model ryzyka, przesuwając odpowiedzialność z wyłącznie operacyjnej na strategiczną, związaną z ochroną długoterminowej wartości firmy. Każda informacja, której cykl życia poufności wykracza poza przewidywany moment pojawienia się CRQC, jest już zagrożona.

Argumenty za odkładaniem migracji do kryptografii postkwantowej (PQC) wyczerpały się. W sierpniu 2024 roku amerykański Narodowy Instytut Standardów i Technologii (NIST) opublikował pierwsze sfinalizowane standardy PQC: FIPS 203 (ML-KEM), FIPS 204 (ML-DSA) oraz FIPS 205 (SLH-DSA). To wydarzenie stanowi kluczowy sygnał dla rynku globalnego: faza badań dobiegła końca, a standardy oczekują na wdrożenie.

Koniec ery „jednego słusznego szyfrowania”

Przez ostatnie dekady decyzje dotyczące kryptografii klucza publicznego były stosunkowo proste, sprowadzając się najczęściej do wyboru między RSA a ECC. Era postkwantowa definitywnie kończy z tym paradygmatem. Wkraczamy w świat, w którym nie ma i nie będzie jednego, uniwersalnego algorytmu PQC. Wybór odpowiedniego rozwiązania staje się świadomą decyzją strategiczną, która musi być precyzyjnie dopasowana do konkretnego przypadku użycia.

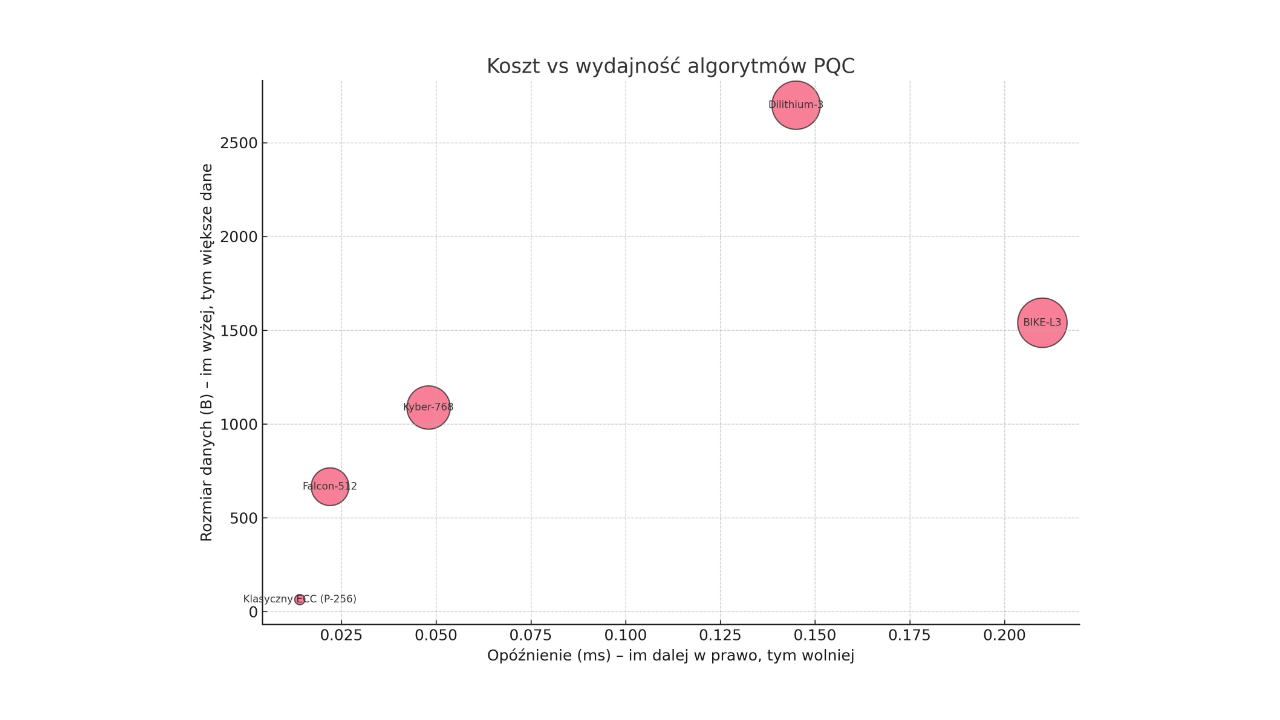

Świat PQC jest z natury heterogeniczny. NIST celowo standaryzuje algorytmy pochodzące z różnych rodzin matematycznych, ponieważ każda z nich oferuje unikalny zestaw kompromisów między wydajnością obliczeniową, rozmiarem danych, wykorzystaniem zasobów a poziomem bezpieczeństwa. Wybór algorytmu przestaje być wyłącznie domeną kryptografów, a staje się decyzją architektoniczną i produktową. Różnice w charakterystyce poszczególnych algorytmów prowadzą do drastycznie odmiennych konsekwencji w zależności od scenariusza wdrożenia.

Dla wysokowydajnych serwerów TLS, obsługujących na przykład front-end e-commerce, priorytetem jest minimalne opóźnienie. Dane z benchmarków jednoznacznie wskazują, że CRYSTALS-Kyber (ML-KEM) jest liderem, oferując znikomy narzut wydajnościowy. Z kolei w sieciach VPN, gdzie kluczowa jest maksymalna przepustowość, problemem mogą stać się algorytmy z bardzo dużymi kluczami, takie jak BIKE, które mogą powodować masową fragmentację pakietów IP i degradację wydajności sieci. W świecie urządzeń IoT, gdzie zasoby są skrajnie ograniczone, algorytmy o wysokich wymaganiach pamięciowych mogą być całkowicie niepraktyczne, bezpośrednio wpływając na koszt komponentów.

Dane mówią same za siebie

Abstrakcyjne dyskusje nabierają realnego kształtu, gdy przeanalizuje się twarde dane. Przełożenie milisekund opóźnień i kilobajtów danych na konkretne implikacje biznesowe jest kluczowe dla podejmowania świadomych decyzji. Analiza oparta na kompleksowych benchmarkach pokazuje, że wybór algorytmu PQC to nie tylko kwestia bezpieczeństwa, ale również realnych kosztów operacyjnych.

Liderem wydajności jest bezsprzecznie CRYSTALS-Kyber, który w testach serwerowych wykazuje znikomy narzut obliczeniowy. Jego klucze publiczne i szyfrogramy są kompaktowe, zajmując łącznie nieco ponad 2 KB, a szczytowe zużycie pamięci RAM jest minimalne, co czyni go idealnym kandydatem do szerokiego spektrum zastosowań. Na drugim biegunie znajduje się BIKE, algorytm oparty na kodach. Mimo swoich zalet, jego wdrożenie wiąże się z konkretnymi kosztami: suma danych wymienianych podczas uzgadniania połączenia przekracza 10 KB, co jest ponad czterokrotnie więcej niż w przypadku Kybera. Taki rozmiar nie tylko zwiększa koszty transferu danych, ale przede wszystkim grozi fragmentacją pakietów sieciowych.

Jeszcze bardziej uderzający jest przykład algorytmu podpisu Falcon. Oferuje on niezwykle małe podpisy, co jest ogromną zaletą w zastosowaniach IoT, gdzie pasmo jest na wagę złota. Jednak jego szczytowe zużycie pamięci jest ponad 26-krotnie wyższe niż w przypadku konkurencyjnego Dilithium. Dla inżyniera projektującego urządzenie medyczne oznacza to, że może być zmuszony do wyboru droższego mikrokontrolera, co podnosi koszt jednostkowy całego produktu.

Ukryte ryzyka i rekomendacje dla CISO

Osiągnięcie zgodności ze standardami PQC to zaledwie pierwszy krok. Największe ryzyka nie leżą w teorii algorytmów, ale w ich praktycznej implementacji. Matematyczna odporność jest bezwartościowa, jeśli fizyczna implementacja na procesorze „przecieka” informacje o tajnym kluczu poprzez ataki kanałem bocznym (side-channel attacks). Badania pokazały już skuteczne ataki na implementacje Kybera i Dilithium, wykorzystujące analizę poboru mocy lub emisji elektromagnetycznych.

Kluczową implikacją dla CISO jest ukryty koszt bezpieczeństwa. Zabezpieczenie implementacji wymaga zastosowania specjalistycznych kontrśrodków, takich jak maskowanie, które wprowadzają znaczący narzut na wydajność. Przedstawiciele NIST przyznali, że dobrze zabezpieczona implementacja Kybera może być nawet dwukrotnie wolniejsza niż jej podstawowa wersja. Oznacza to, że budżety na infrastrukturę, oparte na benchmarkach niezabezpieczonych implementacji, są fundamentalnie błędne.

Kolejnym obszarem ryzyka jest łańcuch dostaw. Bezpieczeństwo systemu PQC jest tak silne, jak jego najsłabsze ogniwo, a te często znajdują się poza kontrolą firmy – w bibliotekach open-source czy u dostawców chmury. CISO musi zacząć zadawać dostawcom trudne pytania o ich roadmapę wdrożenia standardów NIST, wsparcie dla trybów hybrydowych oraz udokumentowaną odporność na ataki fizyczne.

Rozwiązaniem tych wyzwań jest krypto-zwinność (crypto-agility) – zdolność architektury do łatwej i szybkiej wymiany algorytmów kryptograficznych bez fundamentalnych zmian w infrastrukturze. W dynamicznym świecie PQC, gdzie nowe standardy już się pojawiają, takie podejście jest receptą na uniknięcie kosztownych i ryzykownych migracji w przyszłości. Inwestycja w architekturę krypto-zwinną teraz, w ramach pierwszego projektu PQC, jest strategiczną decyzją, która drastycznie obniży całkowity koszt posiadania bezpieczeństwa w nadchodzącej dekadzie.

Migracja do PQC to nie jednorazowy projekt, lecz strategiczny program transformacji. Powinien on przebiegać w sposób metodyczny i fazowy. Pierwszym, fundamentalnym etapem jest dogłębne przygotowanie i inwentaryzacja. Kluczowe jest tu stworzenie szczegółowego inwentarza kryptograficznego, który zmapuje wszystkie systemy wykorzystujące podatną kryptografię. Następnie, na podstawie analizy ryzyka, należy ustalić priorytety migracji, koncentrując się na zasobach o najdłuższym wymaganym cyklu życia poufności. Druga faza to budowanie zdolności technicznych, w tym projektowanie systemów pod kątem wspomnianej krypto-zwinności oraz uruchomienie kontrolowanych projektów pilotażowych w trybach hybrydowych. Takie podejście pozwala zebrać realne dane na temat wpływu PQC na specyficzne środowisko firmy. Ostatnia faza to właściwa, stopniowa migracja systemów produkcyjnych i ustanowienie procesów ciągłego monitorowania.

Przejście na kryptografię postkwantową to ewolucja w zarządzaniu ryzykiem technologicznym. Kluczową, długoterminową inwestycją nie jest wdrożenie konkretnego algorytmu, ale budowa krypto-zwinnej architektury. To właśnie ta zwinność pozwoli firmie na szybką i efektywną adaptację do nieuniknionych zmian w krajobrazie cyberbezpieczeństwa, zapewniając odporność i chroniąc jej przyszłość.