Na konferencji Build 2025 Microsoft ogłosił, że na jego platformie chmurowej Azure pojawił się nowy model językowy – Grok, opracowany przez start-up xAI założony przez Elona Muska. Choć informacja ta może wydawać się jedynie kolejnym krokiem w rozbudowie oferty AI, w rzeczywistości sygnalizuje istotną zmianę kursu. Microsoft stawia na otwartość wobec różnych dostawców sztucznej inteligencji – również tych, którzy mogą być konkurencją dla jego strategicznych partnerów, takich jak OpenAI.

Ten ruch otwiera nowe możliwości dla klientów Azure, ale też rodzi pytania o przyszłość całego ekosystemu chmurowego Microsoftu. Czy otwartość jest atutem w czasach dominacji kilku dużych graczy AI, czy może ryzykiem strategicznym?

Od Copilota do Groka: Microsoft szuka równowagi

Przez ostatnie lata Microsoft budował swój wizerunek lidera w dziedzinie generatywnej AI, głównie w oparciu o bliską współpracę z OpenAI. Modele GPT-4 napędzają szereg produktów firmy, od pakietu Microsoft 365 po narzędzia dla programistów. W tym kontekście pojawienie się Groka w Azure to sygnał, że firma nie chce być zakładnikiem jednego dostawcy.

xAI, założona przez Elona Muska, prezentuje Groka jako alternatywę dla „zbyt ułożonych” modeli innych firm. Sam model zyskał rozgłos m.in. dzięki integracji z X (dawniej Twitterem), ale jego pojawienie się w Azure to coś więcej niż tylko kolejna integracja. Microsoft sygnalizuje, że nie chce być kojarzony wyłącznie z jednym podejściem do AI – i że platforma Azure ma być przestrzenią dla wielu perspektyw.

Różnorodność jako przewaga… i wyzwanie

Z punktu widzenia klientów biznesowych to dobra wiadomość. Różne modele AI oferują różne funkcjonalności, a możliwość wyboru może przynieść realne korzyści – dopasowanie do branż, języka domenowego, kosztów operacyjnych czy polityki przetwarzania danych. Firmy coraz częściej chcą mieć opcję: nie tylko „GPT albo nic”, ale np. Grok do szybkiego przetwarzania mediów społecznościowych, Mistral do pracy offline i Claude do analizy dokumentów.

Jednak otwartość nie jest darmowa. Równoległe zarządzanie wieloma modelami w jednej infrastrukturze chmurowej generuje złożoność – zwłaszcza w zakresie bezpieczeństwa, widoczności i zgodności z regulacjami. To, co dla jednych jest elastycznością, dla innych może być początkiem chaosu.

Ekosystem pod presją

Microsoft z jednej strony promuje Copiloty oparte na GPT, z drugiej udostępnia konkurencyjne rozwiązania – takie jak Grok. Ta dwutorowość może budzić napięcia zarówno w relacjach z partnerami, jak i z klientami końcowymi. Co stanie się z integratorami i dostawcami rozwiązań opartych wyłącznie na OpenAI? Czy będą zmuszeni do dostosowania się do „nowego pluralizmu”, czy raczej zaczną szukać bardziej zamkniętych środowisk?

Z punktu widzenia użytkownika końcowego może to również prowadzić do fragmentacji doświadczenia. Gdy różne narzędzia działają w oparciu o różne modele AI, pojawia się pytanie o spójność wyników, bezpieczeństwo danych i kontrolę nad przepływem informacji.

Bezpieczeństwo: nowa linia frontu

Największe wyzwanie dotyczy jednak bezpieczeństwa. Każdy nowy model w ekosystemie Azure to nowy wektor ataku – niekoniecznie ze względu na złośliwość twórców, ale przez brak standaryzacji, niedoskonałości konfiguracji i ograniczoną przejrzystość.

Wielomodelowe środowisko AI w chmurze oznacza, że nie zawsze wiadomo, kto przetwarza dane, w jaki sposób i w jakim celu. Granica między legalnym a ukrytym wykorzystaniem sztucznej inteligencji staje się coraz trudniejsza do uchwycenia. Firmy, które nie mają odpowiednich narzędzi do inspekcji, audytu i wykrywania anomalii, mogą nawet nie wiedzieć, że ich dane trafiły do modelu, którego nigdy nie zatwierdzały.

To zmusza organizacje do przedefiniowania swojej strategii bezpieczeństwa. Tradycyjne podejścia – takie jak zapory ogniowe czy proste systemy DLP – nie są już wystarczające. Potrzebne są architektury zero trust, zaawansowane mechanizmy analizy behawioralnej i polityki najmniejszych uprawnień, które obejmują nie tylko ludzi, ale i maszyny.

Czy Microsoft stanie się „marketplace’em” dla AI?

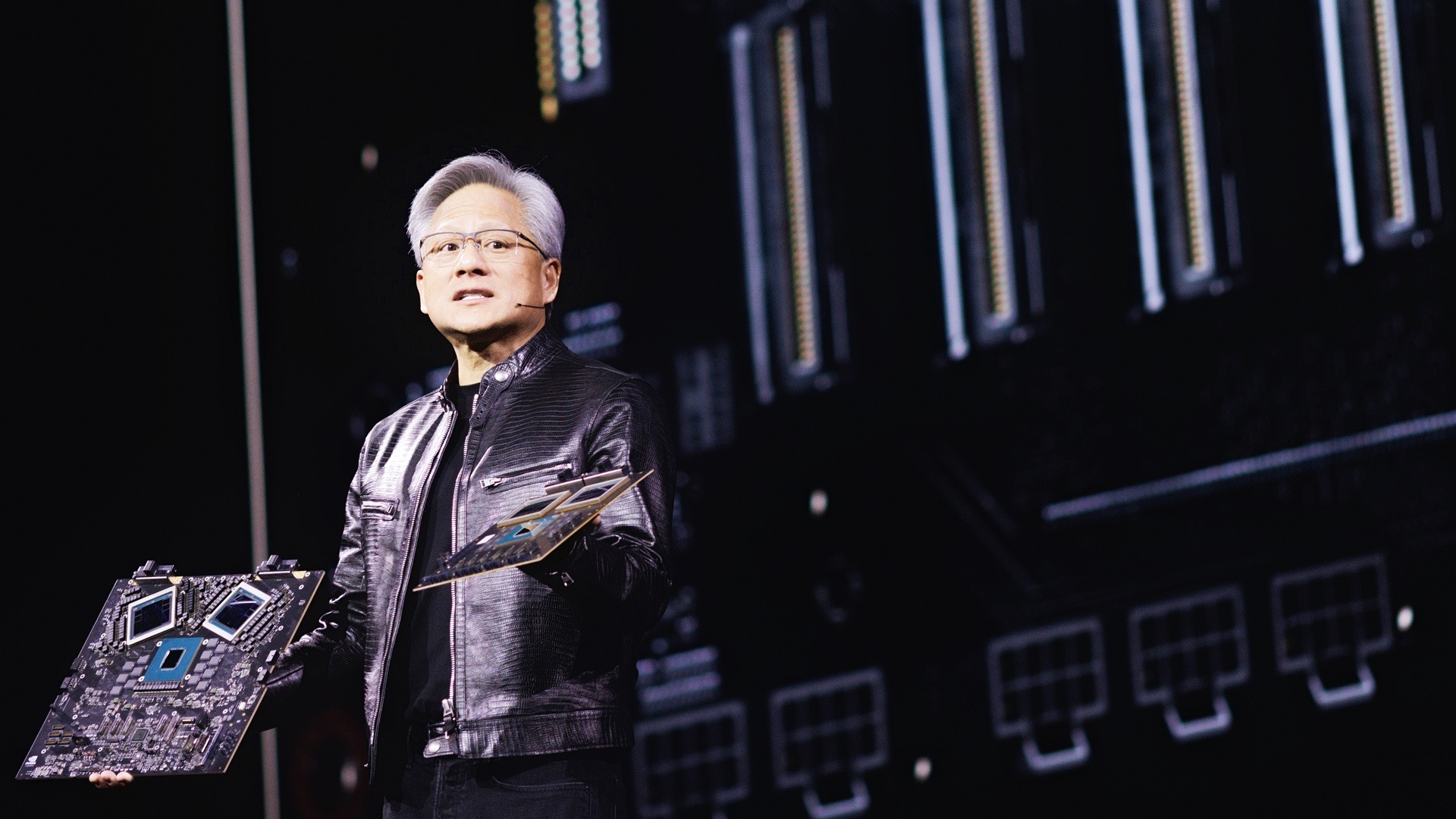

Otwarcie na Groka może być zapowiedzią szerszego trendu – Microsoft może dążyć do uczynienia z Azure czegoś na kształt „App Store’u” dla modeli AI. Klient wybiera, który model chce użyć, a Microsoft zapewnia infrastrukturę, dostęp i integrację.

Z jednej strony to interesujący model biznesowy – Microsoft nie musi inwestować we własne LLM-y w takim stopniu, jeśli stworzy otwartą platformę z modelami od innych firm. Z drugiej – to wymaga silnej kontroli jakości, bezpieczeństwa i zgodności, bez których taka platforma szybko zamieni się w pole minowe.

Pytanie brzmi: czy użytkownicy zaufają platformie, która daje wolność wyboru, ale jednocześnie przerzuca część odpowiedzialności na klienta?

Otwartość to przyszłość – ale wymaga dojrzałości

Otwarcie Azure na alternatywne modele AI to logiczny krok w kierunku demokratyzacji sztucznej inteligencji. Microsoft chce, by jego chmura była miejscem, gdzie można korzystać z dowolnego modelu, dostosowanego do konkretnych potrzeb.

Ale im większa różnorodność, tym większa potrzeba porządku. Firmy muszą nie tylko wybierać najlepsze modele, ale także rozumieć, jak te modele działają, jakie dane przetwarzają i jakie zagrożenia ze sobą niosą. Bez tego, otwartość zamieni się w niekontrolowaną ekspozycję.

Microsoft gra dziś na wielu fortepianach. Pytanie, czy uda mu się utrzymać melodię – czy też zacznie rozbrzmiewać chaos.