Rewolucja związana z generatywną sztuczną inteligencją (GenAI) stworzyła nienasycony popyt na moc obliczeniową, fundamentalnie zmieniając architekturę centrów danych. Tradycyjne procesory (CPU), przez dekady stanowiące serce informatyki, stały się wąskim gardłem dla modeli językowych (LLM) i innych systemów GenAI. W odpowiedzi na to wyzwanie narodziła się nowa klasa wyspecjalizowanego sprzętu: akceleratory AI.

Koniec ery CPU i narodziny nowego paradygmatu

Problem z procesorami CPU w kontekście AI nie leży w ich prędkości, ale w fundamentalnym niedopasowaniu architektonicznym. Zoptymalizowane do sekwencyjnego wykonywania złożonych zadań, posiadają one zaledwie kilka potężnych rdzeni. Tymczasem algorytmy głębokiego uczenia wymagają masowego przetwarzania równoległego – wykonywania bilionów prostych operacji jednocześnie. To zadanie, do którego idealnie nadają się procesory graficzne (GPU), wyposażone w tysiące mniejszych rdzeni .

Obok GPU, które stały się standardem w treningu modeli, wyłoniły się jeszcze bardziej wyspecjalizowane jednostki. Neuronalne jednostki przetwarzające (NPU) to szeroka kategoria układów zaprojektowanych od podstaw z myślą o AI, priorytetyzujących efektywność energetyczną, co czyni je kluczowymi w zastosowaniach brzegowych (Edge AI). Z kolei tensorowe jednostki przetwarzające (TPU) to autorskie układy ASIC firmy Google, zoptymalizowane pod kątem jej ekosystemu oprogramowania i masowych obliczeń w chmurze .

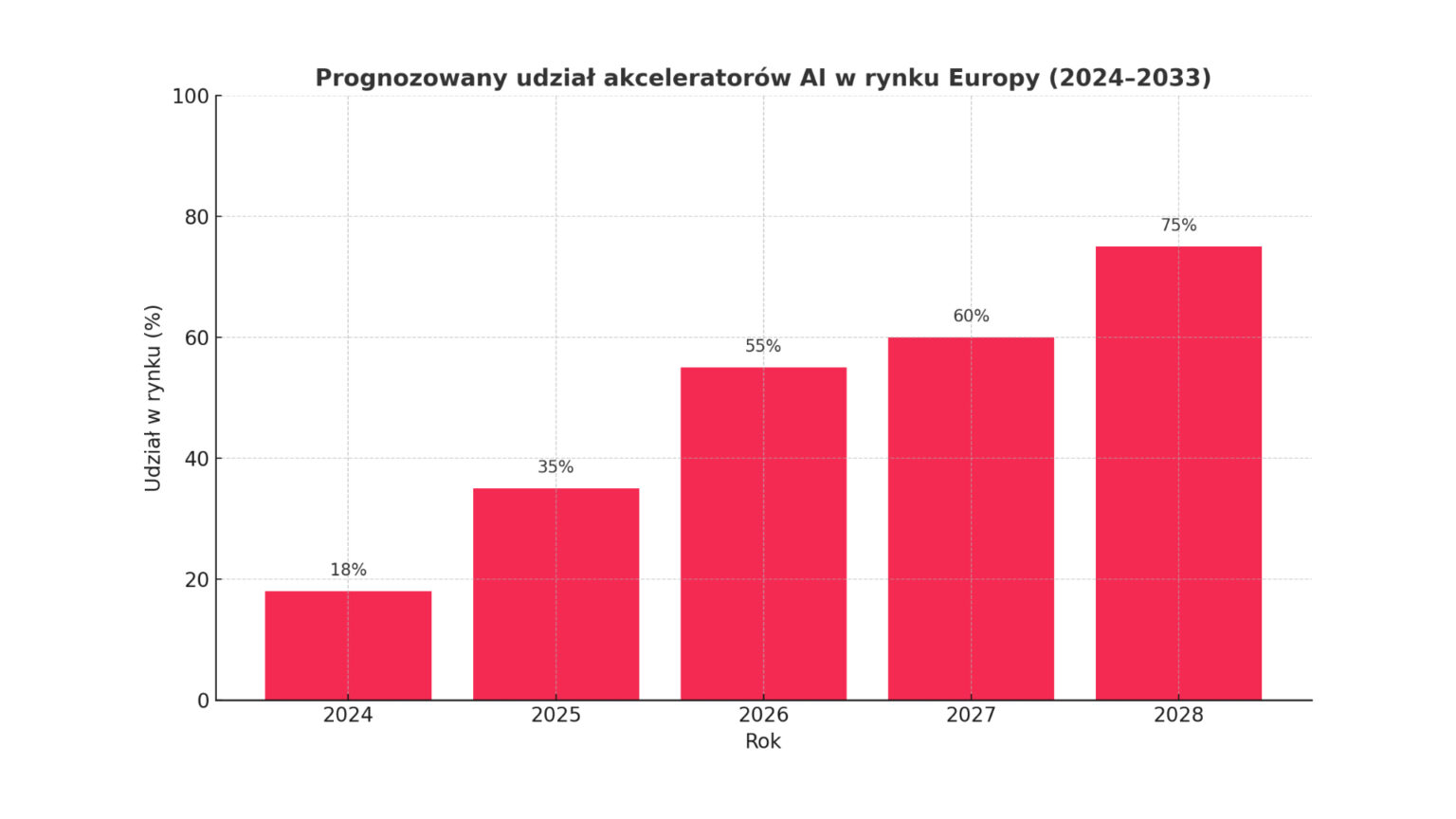

Ta zmiana paradygmatu napędza w Europie rynek o ogromnym potencjale. Wyceniany w 2024 roku na około 4,88 miliarda euro, europejski rynek akceleratorów AI ma wzrosnąć do blisko 43 miliardów euro do 2033 roku, przy imponującym skumulowanym rocznym wskaźniku wzrostu (CAGR) na poziomie 27,4% .

Unikalne europejskie drivery: Polityka spotyka popyt rynkowy

Europejski rynek akceleratorów jest kształtowany przez unikalne połączenie oddolnego popytu komercyjnego i odgórnych inicjatyw strategicznych, co odróżnia go od rynków w USA czy Azji.

Z jednej strony, rośnie adopcja AI w kluczowych sektorach, takich jak opieka zdrowotna, motoryzacja i finanse. Już 13,5% przedsiębiorstw w UE korzysta z technologii AI, a cały europejski rynek AI (oprogramowanie, sprzęt i usługi) rośnie w tempie ponad 33% rocznie.

Z drugiej strony, Unia Europejska realizuje ambitny program wzmacniania swojej suwerenności cyfrowej i technologicznej. Obawy geopolityczne i chęć uniezależnienia się od pozaunijnych dostawców doprowadziły do powstania potężnych mechanizmów inwestycyjnych:

- EU Chips Act: Inicjatywa ta ma na celu zmobilizowanie ponad 43 miliardów euro w inwestycjach publicznych i prywatnych, aby do 2030 roku podwoić udział Europy w globalnej produkcji półprzewodników z 10% do 20% . Przyciąganie inwestycji w budowę zaawansowanych fabryk, takich jak zakłady Intela czy TSMC w Niemczech, ma kluczowe znaczenie dla przyszłej produkcji akceleratorów w Europie.

- AI Continent Action Plan: Ten opiewający na 200 miliardów euro plan zakłada stworzenie suwerennego, paneuropejskiego ekosystemu AI. Jego kluczowym elementem jest inicjatywa InvestAI, która ma zmobilizować 20 miliardów euro na budowę 4-5 „Gigafabryk AI” – każda wyposażona w ponad 100 000 zaawansowanych chipów AI.

- EuroHPC i „Fabryki AI”: Wspólne Przedsięwzięcie w dziedzinie Europejskich Obliczeń Wielkiej Skali (EuroHPC JU) inwestuje miliardy euro w budowę floty superkomputerów. Wokół nich powstaje 13 „Fabryk AI”, które demokratyzują dostęp do mocy obliczeniowej dla startupów i MŚP, stymulując innowacje i tworząc gwarantowany popyt na infrastrukturę .

Krajobraz konkurencyjny: Dominacja Nvidii i strategie pretendentów

Rynek akceleratorów dla centrów danych jest bliski monopolu. Nvidia kontroluje około 98% globalnego rynku pod względem liczby dostarczonych jednostek, a jej prawdziwą przewagą jest dojrzały ekosystem oprogramowania CUDA, z którego korzysta 5 milionów deweloperów . Tworzy to potężny efekt „lock-in”, utrudniając konkurentom zdobycie udziałów.

Mimo to pretendenci realizują przemyślane strategie:

- AMD: Pozycjonuje się jako główna, wysokowydajna alternatywa. Seria akceleratorów Instinct MI300 ma konkurować z ofertą Nvidii, a jej kluczowym atutem jest otwarta platforma oprogramowania ROCm, mająca na celu przełamanie monopolu CUDA.

- Intel: Stawia na konkurencję cenową z akceleratorami Gaudi (mają być o 50% tańsze od H100 Nvidii) oraz na otwarty ekosystem oneAPI.

- Google (TPU): Nie sprzedaje chipów bezpośrednio, lecz wykorzystuje je jako kluczowy element wyróżniający swoją platformę chmurową, oferując doskonały stosunek wydajności do kosztów dla specyficznych obciążeń AI.

Na tym tle pojawiają się również europejscy gracze, tacy jak brytyjski Graphcore czy francuski Blaize, którzy koncentrują się na niszach, takich jak nowatorskie architektury (IPU) czy energooszczędne układy dla Edge AI

Trylemat wzrostu: Koszt, energia i talent

Pomimo optymistycznych prognoz, europejski rynek napotyka trzy fundamentalne bariery, które tworzą strategiczny trylemat dla decydentów.

Koszt i dostępność: Cena pojedynczego akceleratora z najwyższej półki, jak Nvidia H100, sięga 40 000 USD, co czyni budowę własnej infrastruktury AI zaporową dla większości firm . Dodatkowo, globalne łańcuchy dostaw są wrażliwe na zakłócenia i kontrole eksportu, co zagraża ciągłości projektów .

Energia i ESG: Centra danych dedykowane AI zużywają od czterech do pięciu razy więcej energii niż tradycyjne. Prognozuje się, że do 2030 roku zużycie energii przez centra danych w Europie wzrośnie niemal trzykrotnie. Stoi to w sprzeczności z ambitnymi celami UE w zakresie zrównoważonego rozwoju, takimi jak

Dyrektywa w sprawie efektywności energetycznej, która nakłada obowiązek redukcji zużycia energii.

Talent: Europa boryka się z krytycznym niedoborem specjalistów w dziedzinie AI i HPC. Luka kompetencyjna spowalnia innowacje i uniemożliwia firmom efektywne wykorzystanie nawet już posiadanej infrastruktury, wzmacniając pozycję globalnych dostawców chmury.

Trendy na przyszłość: Od posiadania do dostępu, od monolitu do modułu

W perspektywie do 2030 roku rynek będzie kształtowany przez trzy kluczowe trendy:

- Dominacja modelu „Compute-as-a-Service”: Ze względu na wspomniany trylemat, większość firm nie będzie kupować akceleratorów, lecz wynajmować do nich dostęp. Model ten, realizowany zarówno przez publiczne „Fabryki AI”, jak i komercyjnych dostawców chmury, przekształca ogromne wydatki kapitałowe (CAPEX) w przewidywalne koszty operacyjne (OPEX).

- Bitwa o oprogramowanie: Długoterminowa struktura rynku zależeć będzie od sukcesu otwartych standardów, takich jak ROCm i oneAPI, w przełamywaniu dominacji CUDA. Uniknięcie uzależnienia od jednego dostawcy jest potężnym motywatorem dla całej branży

Nowe architektury sprzętowe: Aby przezwyciężyć fizyczne ograniczenia, branża zmierza w kierunku chipletów – mniejszych, wyspecjalizowanych kostek krzemowych łączonych w jeden system. Pozwala to na większą modułowość i niższe koszty. W dłuższej perspektywie rewolucją mogą okazać się

obliczenia fotoniczne, wykorzystujące światło zamiast elektronów, co obiecuje o rzędy wielkości większą przepustowość i efektywność energetyczną .

Wnioski strategiczne dla liderów technologicznych

Europejski rynek akceleratorów AI to arena, na której globalna konkurencja technologiczna spotyka się z unikalnymi ambicjami politycznymi i regulacyjnymi. Dla dyrektorów ds. technologii i innowacji oznacza to konieczność nawigowania w złożonym ekosystemie.

Kluczowe pytanie strategiczne przesuwa się z „jaki akcelerator kupić?” na „jak strategicznie uzyskać dostęp do mocy obliczeniowej?”. Odpowiedź wymaga zbalansowania wydajności, kosztów, suwerenności i zrównoważonego rozwoju. Sukces w erze GenAI nie będzie zależał od samego posiadania najnowszego sprzętu, ale od umiejętności inteligentnego wykorzystania zarówno publicznych inicjatyw, jak i prywatnych innowacji do budowania trwałej przewagi konkurencyjnej na unikalnym europejskim rynku.