Rewolucja sztucznej inteligencji (AI) napędza bezprecedensowy popyt na dwa kluczowe zasoby: energię elektryczną i wyspecjalizowane półprzewodniki. Giganci technologiczni i rynki finansowe malują obraz niemal nieograniczonego wzrostu, jednak pod powierzchnią tej narracji kryje się fundamentalny konflikt. Z jednej strony mamy do czynienia z wykładniczo rosnącymi prognozami zapotrzebowania na energię ze strony centrów danych. Z drugiej – napotykamy twarde, fizyczne i geopolityczne ograniczenia globalnej zdolności do produkcji zaawansowanych chipów, które są niezbędne do zasilania tej rewolucji. Te dwa trendy, nierozerwalnie ze sobą związane, zdają się pędzić po kursie kolizyjnym.

Przełomowy raport opublikowany przez London Economics International (LEI) jako pierwszy skwantyfikował tę sprzeczność. Analiza LEI obnaża, że prognozy dotyczące popytu na energię w samych Stanach Zjednoczonych, gdy przełoży się je na zapotrzebowanie na chipy, stają się niemożliwe do zrealizowania w kontekście realistycznych scenariuszy globalnej podaży.

Złota gorączka AI: tsunami popytu na energię

Obecna era technologiczna jest zdominowana przez zjawisko, które można trafnie określić mianem „złotej gorączki AI”. Napędza ona inwestycje na niespotykaną dotąd skalę, co widać najwyraźniej w dynamicznym wzroście rynku centrów danych – fizycznej infrastruktury stanowiącej kręgosłup sztucznej inteligencji. Globalny rynek centrów danych ma wzrosnąć z około 347,6 mld USD w 2024 roku do ponad 652 mld USD do roku 2030. Motorem tego wzrostu jest rosnące zapotrzebowanie na usługi chmurowe, technologie Internetu Rzeczy (IoT) oraz, przede wszystkim, aplikacje AI.

Sztuczna inteligencja, a w szczególności jej generatywna odmiana, jest głównym katalizatorem wykładniczego wzrostu zapotrzebowania na energię. Trening dużych modeli AI jest procesem niezwykle intensywnym energetycznie, a ich późniejsze wykorzystanie (inferencja) również zużywa znacznie więcej energii niż tradycyjne zadania obliczeniowe. Szacuje się, że pojedyncze zapytanie do modelu takiego jak ChatGPT zużywa około 10 razy więcej energii niż tradycyjne wyszukiwanie w Google. Co więcej, dedykowane akceleratory AI, takie jak procesory graficzne (GPU), zużywają znacznie więcej energii niż tradycyjne procesory (CPU).

Skala tego energetycznego tsunami znajduje odzwierciedlenie w prognozach wiodących instytucji. Międzynarodowa Agencja Energetyczna (IEA) ostrzega, że globalne zużycie energii przez centra danych może się podwoić do 2026 roku. Goldman Sachs szacuje, że do 2030 roku globalne zapotrzebowanie na moc ze strony centrów danych wzrośnie o 165% w porównaniu z rokiem 2023, a udział samej AI w tym zapotrzebowaniu wzrośnie z 14% do 27% już w 2027 roku. W Stanach Zjednoczonych prognozy są jeszcze bardziej dramatyczne – do 2030 roku centra danych mogą odpowiadać za 9% do 12% całkowitego krajowego zużycia energii, w porównaniu do około 4,4% w 2023 roku. Za tym boomem stoją głównie tzw. hyperscalersi – Amazon, Google, Microsoft i Meta – którzy tylko w 2024 roku planują wydać 217 mld USD na infrastrukturę AI.

Wielka sprzeczność: matematyka niemożliwości

W obliczu tak astronomicznych prognoz, raport LEI stanowi otrzeźwiający głos rozsądku. Jego autorzy poddają w wątpliwość wiarygodność prognoz dotyczących potrzeb energetycznych, demaskując fundamentalną sprzeczność między deklarowanym popytem a fizycznymi możliwościami jego zaspokojenia.

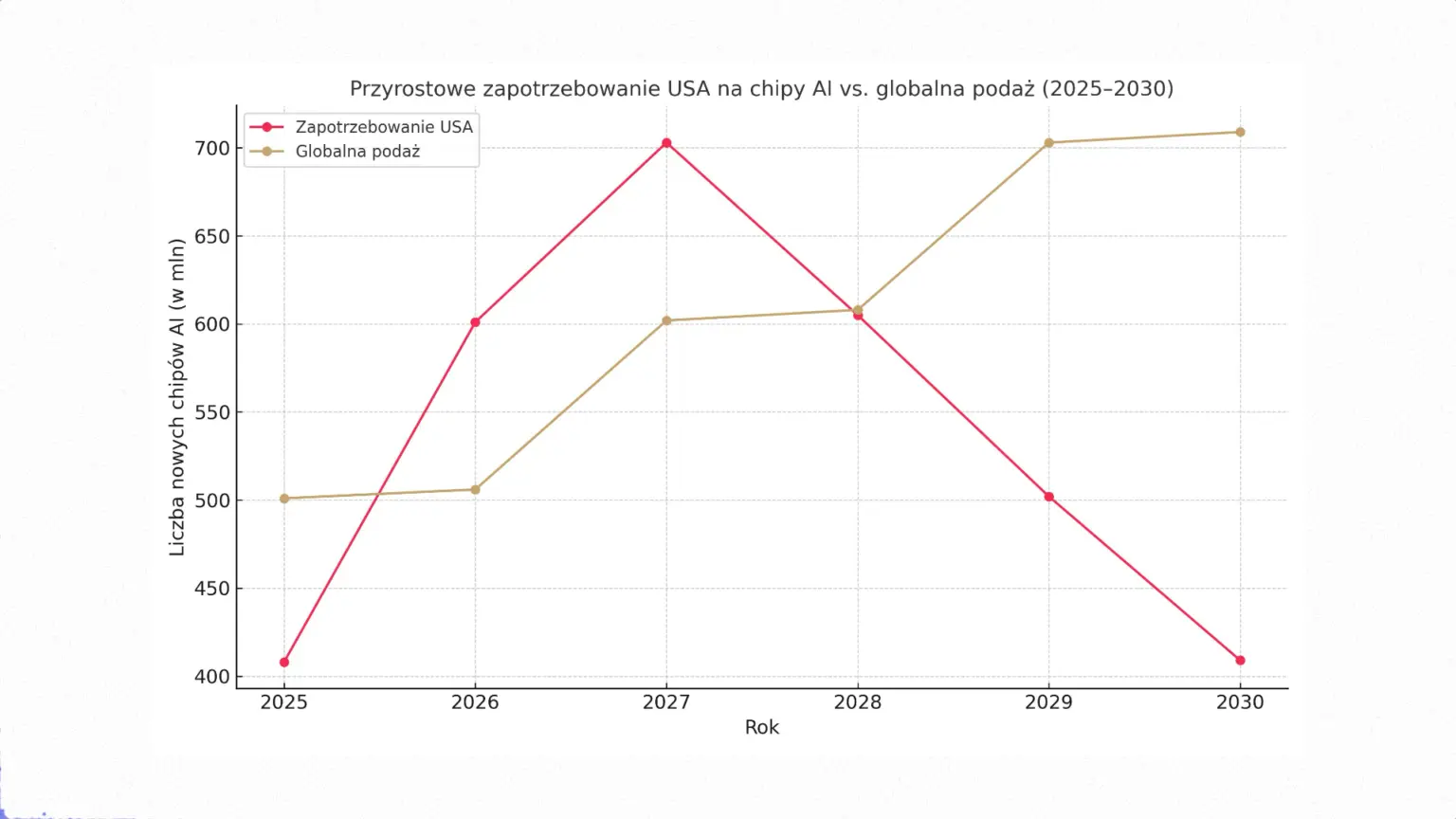

Kluczowy argument raportu jest prosty, lecz uderzający: prognozy zapotrzebowania na energię dla centrów danych w USA są systematycznie przeszacowywane i w konsekwencji niewiarygodne. Aby to udowodnić, LEI zastosowało innowacyjną metodologię, porównując zagregowane prognozy popytu na energię z fizyczną, globalną zdolnością do produkcji kluczowego komponentu – zaawansowanych chipów AI.

Wyniki tej analizy są jednoznaczne. LEI zagregowało prognozy zapotrzebowania na moc ze strony amerykańskich operatorów sieci, obejmujące 77% rynku energetycznego USA. Wynikało z nich, że w latach 2025-2030 powstanie zapotrzebowanie na dodatkowe 57 GW mocy. Następnie, analitycy oszacowali, że nawet przy bardzo optymistycznych założeniach dotyczących wzrostu globalnej produkcji chipów AI, całkowita nowa podaż w tym okresie będzie w stanie zaspokoić zapotrzebowanie na poziomie odpowiadającym 63 GW nowej mocy w centrach danych na całym świecie.

Zestawienie tych dwóch liczb prowadzi do szokującego wniosku: aby zrealizować prognozy amerykańskich operatorów, Stany Zjednoczone musiałyby zaabsorbować ponad 90% całej nowej globalnej podaży chipów AI wyprodukowanych na świecie w latach 2025-2030. Taki scenariusz jest w oczywisty sposób nierealistyczny. Obecnie USA odpowiadają za mniej niż 50% globalnego popytu na chipy, a inne regiony, takie jak Europa i Azja, również dynamicznie rozwijają swoje zdolności AI. Wniosek jest nieunikniony: prognozy, na których opierają się plany rozbudowy amerykańskiej energetyki, są fundamentalnie niewiarygodne i oderwane od fizycznych realiów globalnej produkcji.

Kruche fundamenty: geopolityka, technologia i talent

Sprzeczność zdemaskowana przez raport LEI ma swoje głębokie korzenie w niezwykle złożonej i podatnej na zakłócenia strukturze globalnego łańcucha dostaw półprzewodników.

Po pierwsze, geopolityka. Globalna produkcja jest zdominowana przez zaledwie kilka krajów i firm. W centrum tego ekosystemu znajduje się Tajwan, a konkretnie firma TSMC, która kontroluje ponad 90% rynku najbardziej zaawansowanych chipów. Cała gospodarka cyfrowa jest de facto zakładnikiem stabilności politycznej w Cieśninie Tajwańskiej. Drugim filarem jest Korea Południowa, z firmami Samsung i SK Hynix, które dominują na rynku pamięci, w tym kluczowych dla AI pamięci HBM. Ten skoncentrowany krajobraz stał się areną wojny technologicznej między USA a Chinami, co prowadzi do fragmentacji rynku i zakłóceń w łańcuchach dostaw.

Po drugie, technologia. Kluczowym wąskim gardłem jest zaawansowane pakowanie. Technologia CoWoS (Chip-on-Wafer-on-Substrate), zdominowana przez TSMC, jest niezbędna do integracji wielu chipletów w jeden super-procesor AI. Moce produkcyjne CoWoS, mimo dynamicznego zwiększania, nie nadążają za eksplodującym popytem, co stanowi główny czynnik ograniczający podaż najpotężniejszych akceleratorów.

Po trzecie, ludzie. Nawet jeśli udałoby się pokonać bariery geopolityczne i technologiczne, na drodze stoi brak wykwalifikowanych kadr. Szacuje się, że do 2030 roku w samych Stanach Zjednoczonych w branży zabraknie około 67 000 specjalistów. W skali globalnej ta luka może sięgać setek tysięcy. Nowe fabryki budowane w ramach inicjatyw takich jak CHIPS Act mogą pozostać puste z powodu braku inżynierów i techników do ich obsługi.

Unikając zderzenia: efektywność i innowacja

W obliczu nieuniknionego zderzenia, branża technologiczna musi dokonać strategicznego zwrotu. Droga wyjścia z impasu wiedzie przez dwie ścieżki: radykalną poprawę efektywności i poszukiwanie nowych paradygmatów obliczeniowych.

W perspektywie krótkoterminowej kluczowa jest efektywność. Koncepcja „Green AI” zakłada projektowanie modeli z myślą o minimalizacji ich śladu energetycznego. Techniki takie jak optymalizacja modeli (np. pruning, kwantyzacja) mogą znacząco zredukować zapotrzebowanie na moc obliczeniową. Równie ważna jest efektywność infrastruktury. Przejście z chłodzenia powietrzem na znacznie wydajniejsze chłodzenie cieczą może zredukować zużycie energii w centrum danych nawet o 40%. Należy jednak pamiętać o tzw. efekcie odbicia (paradoks Jevonsa), gdzie poprawa wydajności może prowadzić do jeszcze większego zużycia zasobów.

W perspektywie długoterminowej potrzebny jest przełom technologiczny. Dwie najbardziej obiecujące technologie to fotonika i obliczenia neuromorficzne. Obliczenia fotoniczne, wykorzystujące światło zamiast elektronów, oferują teoretycznie o rzędy wielkości wyższą przepustowość i niższe zużycie energii. Z kolei obliczenia neuromorficzne, inspirowane architekturą ludzkiego mózgu, są z natury bardziej energooszczędne w zadaniach AI. Należy jednak zachować realizm – technologie te nie będą gotowe do masowego wdrożenia przed końcem dekady.

Wyjście poza niemożliwy wyścig

Analiza prowadzi do jednoznacznego wniosku: „niemożliwy wyścig po chipy” nie jest odległą groźbą, ale teraźniejszością. Obecna trajektoria wzrostu jest niezrównoważona. Ograniczenia mają charakter systemowy – napięcia geopolityczne, technologiczne wąskie gardła i globalna luka talentów tworzą sieć powiązanych ze sobą barier.

W tej sytuacji konieczna jest zmiana myślenia. Prawdziwym zwycięstwem w tym wyścigu nie będzie zbudowanie największego i najbardziej energochłonnego superkomputera. Zwycięstwem będzie opracowanie fundamentalnie nowej, zrównoważonej ścieżki rozwoju. Przyszłość nie należy do tych, którzy będą w stanie zasilić najbardziej monstrualne modele AI, ale do tych, którzy wymyślą, jak osiągnąć te same lub lepsze rezultaty przy radykalnie niższym zużyciu energii i zasobów. To już nie jest wyścig na surową moc obliczeniową. To wyścig na inteligencję – zarówno tę sztuczną, którą tworzymy, jak i tę ludzką, której musimy użyć, aby zarządzać tą transformacją w sposób odpowiedzialny. Wyjście poza „niemożliwy wyścig” wymaga przejścia od paradygmatu „więcej” do paradygmatu „mądrzej”. To największe wyzwanie i zarazem największa szansa, jaka stoi przed branżą technologiczną w nadchodzącej dekadzie.