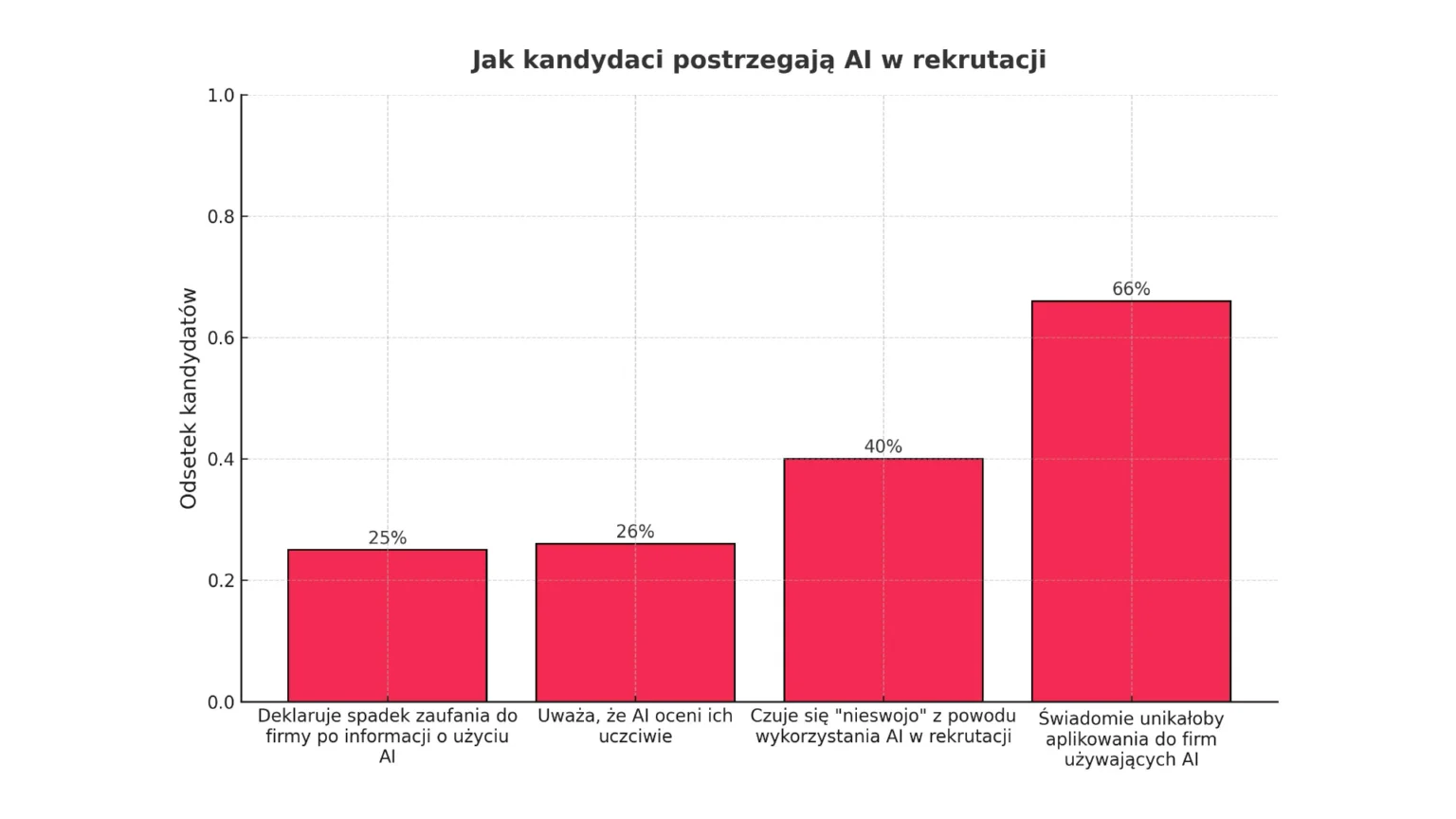

Sztuczna inteligencja miała być obiektywnym sędzią w rekrutacji, a stała się niewidzialną barierą, której kandydaci boją się bardziej niż ludzkiej oceny. Obietnica efektywności i bezstronności, napędzająca masowe inwestycje w technologie HR, zderza się z brutalną rzeczywistością rynku pracy. Firmy, dążąc do optymalizacji, wdrażają zautomatyzowane systemy na niespotykaną dotąd skalę – w 2025 roku już 87% organizacji na świecie korzysta z narzędzi opartych na AI.Jednak po drugiej stronie tego technologicznego zbrojenia narasta fundamentalny kryzys zaufania. Zaledwie co czwarty kandydat (26%) wierzy, że algorytm oceni go uczciwie, a miażdżące 66% dorosłych Amerykanów deklaruje, że świadomie unikałoby aplikowania do firm wykorzystujących AI w procesie decyzyjnym.

Ta przepaść między korporacyjną strategią a odczuciami kandydatów nie jest jedynie statystyczną anomalią. To epicentrum sejsmicznego wstrząsu, który redefiniuje zasady gry o talent. Sztuczna inteligencja, zamiast być transparentnym narzędziem, staje się dla kandydatów nieprzeniknioną „czarną skrzynką”, generując głęboką nieufność, która niszczy markę pracodawcy i zmusza najlepszych specjalistów do poszukiwania procesów z ludzką twarzą.

Anatomia strachu: werdykt bez dialogu

Niechęć do AI w rekrutacji nie jest irracjonalną obawą przed nowością. To logiczna reakcja na proces, który staje się nieprzenikniony i pozbawiony ludzkiego pierwiastka. Strach ten ma złożone podłoże, wynikające z fundamentalnych obaw o bycie ocenionym przez bezduszną maszynę bez możliwości dialogu, wyjaśnienia czy odwołania.

Dla kandydata odrzucenie aplikacji jest zawsze trudnym doświadczeniem. Jednak odmowa ze strony rekrutera pozostawia przestrzeń na ludzką interpretację. Odrzucenie przez algorytm jest czymś zupełnie innym – to zimny, ostateczny werdykt, który nie oferuje żadnego wyjaśnienia. To właśnie ta bezduszność budzi największy lęk. Dane potwierdzają skalę tego zjawiska: 32% kandydatów obawia się, że AI niesłusznie odrzuci ich aplikację. Ta obawa nie jest bezpodstawna. Szacuje się, że nawet 40% wszystkich aplikacji jest automatycznie odrzucanych przez systemy śledzenia kandydatów (ATS) i algorytmy AI, zanim jeszcze trafią one na biurko rekrutera.

Problem zaufania pojawia się na samym początku interakcji. Sama informacja o wykorzystaniu AI działa jak czerwona flaga. Według badań Gartnera, 25% kandydatów deklaruje, że ich zaufanie do firmy maleje, gdy dowiadują się, że ta używa AI do oceny ich kandydatury. Głównym źródłem lęku jest całkowita nieprzejrzystość kryteriów oceny. Kandydaci czują, że biorą udział w grze, której zasad nie znają. Czy liczą się tylko słowa kluczowe? Czy algorytm analizuje styl pisania, a w przypadku rozmowy wideo – mikroekspresje i ton głosu? Ta nieprzenikalność, określana mianem „problemu czarnej skrzynki” (black box problem), jest kluczowa.

Efekt mrocznego lustra – jak nieufność niszczy markę pracodawcy

Nieufność kandydatów przekłada się na twarde, mierzalne konsekwencje, które uderzają w markę pracodawcy i efektywność rekrutacji. Technologia wdrożona w celu poprawy wizerunku zaczyna odbijać i potęgować najgorsze obawy kandydatów, prowadząc do kryzysu wiarygodności i realnych strat.

Najbardziej alarmującym sygnałem jest erozja zaufania do samego procesu rekrutacyjnego. Kiedy kandydaci stykają się z bezosobowymi, zautomatyzowanymi systemami, ich sceptycyzm wobec narzędzia szybko przeradza się w sceptycyzm wobec intencji firmy. Dane z ankiety Gartnera są wstrząsające: aż połowa kandydatów (50%) przyznała, że miała wątpliwości, czy ogłoszenie o pracę, na które aplikuje, jest w ogóle legalne i prawdziwe. Oznacza to, że co drugi potencjalny pracownik, widząc zautomatyzowany proces, zaczyna podejrzewać, że ma do czynienia z oszustwem.

Kryzys wiarygodności ma bezpośrednie przełożenie na kluczowe wskaźniki. Kandydaci, czując się niepewnie, stają się bardziej selektywni. Twardym dowodem jest spadek wskaźnika akceptacji ofert pracy: z 74% w drugim kwartale 2023 roku do zaledwie 51% w drugim kwartale 2025 roku. Prawie połowa kandydatów odmawia, zniechęcona brakiem zaufania. Negatywne doświadczenia, takie jak zła komunikacja, były powodem odrzucenia oferty przez 26% kandydatów.

Widmo algorytmicznego uprzedzenia – co kryje się w „czarnej skrzynce”?

Najgłębsza warstwa lęku kandydatów dotyczy widma systemowej, zautomatyzowanej dyskryminacji. Obawa, że algorytm, zamiast być obiektywnym sędzią, stanie się egzekutorem historycznych uprzedzeń, jest potwierdzona przez głośne porażki wdrożeń AI.

Podstawowa zasada działania systemów uczenia maszynowego jest ich największą słabością: AI uczy się na podstawie dostarczonych danych. Jeśli dane historyczne odzwierciedlają istniejące uprzedzenia – dotyczące płci, rasy, wieku czy pochodzenia – sztuczna inteligencja nie tylko je odtworzy, ale zrobi to na masową skalę.

Historia próby wdrożenia zautomatyzowanego systemu rekrutacyjnego przez Amazona stała się podręcznikowym przykładem tego, jak działają algorytmiczne uprzedzenia. W 2014 roku Amazon rozpoczął pracę nad narzędziem, które miało automatyzować przeglądanie CV. Inżynierowie oparli modele na analizie CV z poprzednich 10 lat, w których dominowali mężczyźni. W rezultacie algorytm zaczął systematycznie karać kandydatki, negatywnie oceniając CV zawierające słowo „women’s” (np. w nazwie „women’s chess club captain”) i obniżając ocenę absolwentkom uczelni przeznaczonych wyłącznie dla kobiet. Mimo prób naprawy, projekt został ostatecznie zamknięty w 2018 roku.

Problem wykracza poza kwestie płci czy rasy. Optymalizując proces pod kątem historycznego „idealnego kandydata”, AI stwarza zagrożenie dla różnorodności. Faworyzuje linearne ścieżki kariery, penalizując osoby, które mają przerwy w zatrudnieniu (co często dotyka kobiety) lub zmieniły branżę. To jest istota „szklanej ściany” – niewidzialnej bariery, która odrzuca kreatywnych myślicieli i innowatorów.

Tęsknota za autentycznością i model hybrydowy

W obliczu rosnącej nieufności, rynek pracy wysyła wyraźny sygnał: tęsknotę za autentycznością. Kandydaci coraz częściej poszukują interakcji z człowiekiem jako gwarancji wiarygodności. Nie oznacza to rezygnacji z technologii, ale poszukiwanie inteligentnego modelu hybrydowego.

W erze zdominowanej przez automatyzację, zaproszenie na bezpośrednią rozmowę z rekruterem nabiera nowego znaczenia. Staje się dla kandydata kluczowym sygnałem – certyfikatem wiarygodności. Twarde dane z badań Gartnera są jednoznaczne: aż 62% kandydatów jest bardziej skłonnych aplikować do firmy, jeśli w procesie rekrutacyjnym wymagana jest rozmowa osobista. W świecie, w którym 50% kandydatów wątpi w autentyczność ogłoszeń, obietnica rozmowy z człowiekiem staje się potężnym narzędziem budowania zaufania.

Kluczem do rozwiązania kryzysu jest mądra integracja technologii. Model hybrydowy, w którym AI i człowiek działają w synergii, jest najbardziej obiecującą ścieżką. AI powinna być używana do automatyzacji zadań powtarzalnych, takich jak wstępny screening CV, planowanie rozmów czy analiza danych. Kluczowe, wymagające empatii etapy muszą pozostać w rękach człowieka: budowanie relacji, ocena dopasowania kulturowego i ostateczna decyzja.

Wiele wiodących firm już teraz z powodzeniem wdraża modele hybrydowe. Unilever, przetwarzając 1,8 miliona aplikacji rocznie, wdrożył dwuetapowy proces oparty na AI, ale ostateczna decyzja należała do ludzi. Wyniki? Oszczędność ponad 1 miliona funtów rocznie, skrócenie czasu rekrutacji o 75-90% i wzrost różnorodności o 16%.

Nowe ramy gry – AI Act

Debata na temat zaufania przestała być jedynie dyskursem etycznym. Wraz z wejściem w życie przełomowego Aktu o Sztucznej Inteligencji (EU AI Act), przekształciła się w twardą rzeczywistość prawną.

Unijny AI Act klasyfikuje systemy AI używane w zatrudnieniu jako działalność „wysokiego ryzyka”. Uruchamia to zestaw rygorystycznych wymogów, które muszą być spełnione przed wdrożeniem systemu. Dla firm oznacza to koniec ery „dzikiego zachodu” w HR Tech. Akt nakłada na pracodawców („wdrażających”) konkretne obowiązki, w tym informowanie kandydatów o wykorzystaniu systemu AI, zapewnienie nadzoru ludzkiego z uprawnieniami do korygowania decyzji AI oraz przeprowadzenie oceny wpływu na prawa podstawowe przed wdrożeniem. Co więcej, akt kategorycznie zakazuje używania systemów AI do wnioskowania o emocjach osób w miejscu pracy, co bezpośrednio uderza w narzędzia do analizy wideo.

Nieufność wobec AI w rekrutacji to nie irracjonalny lęk, ale logiczna reakcja na brak transparentności, ryzyko stronniczości i postępującą dehumanizację. Firmy, które zignorują te sygnały, przegrają walkę o talenty, ponosząc realne koszty.

Kluczem do sukcesu nie jest lepsza AI, ale radykalna transparentność. Zwycięzcami będą organizacje, które jasno komunikują, jak używają technologii, gwarantują, że ostateczna decyzja i autentyczny kontakt zawsze pozostaną w rękach człowieka, traktują EU AI Act nie jako obciążenie, ale jako przepis na budowanie zaufania, oraz inwestują w ludzki wymiar procesu.

Przyszłość rekrutacji nie polega na wyborze między człowiekiem a maszyną, ale na znalezieniu mądrej synergii, w której technologia służy człowiekowi. W tej nowej rzeczywistości zaufanie nie jest już „miękkim” dodatkiem – staje się najtwardszą walutą na rynku pracy.