Tegoroczne Dell Technologies Forum ponownie przyciągnęło do Warszawy tłumy – ponad 2700 gości to wynik, który pokazuje skalę tego cyklicznego wydarzenia. Hasło przewodnie „AI. Po prostu.” brzmiało jak prowokacja, jednak szybko okazało się, że organizatorom nie chodziło o trywializowanie AI, ale o zasygnalizowanie zmiany. Na forum głośno mówiono, że czas eksperymentów i Shadow AI powinien dobiec końca. Teraz nadszedł czas na wdrożenia, które można efektywnie wykorzystać w biznesie oraz zmierzyć rzeczywisty zwrot z inwestycji.

Receptą Della na ten nowy etap ma być Fabryka AI (AI Factory), czyli koncepcja planu wdrożeniowego dla firm. Co kluczowe, plan ten opiera się na tezie, że o sukcesie AI decyduje dziś nie tylko sam algorytm, ale w równej mierze posiadanie odpowiedniej infrastruktury, zdolnej przetwarzać dane blisko miejsca ich powstawania (Edge Computing).

Postanowiłam odejść od oficjalnej agendy, by sprawdzić, co realnie kryje się za hasłem „AI. Po prostu.”. Kluczowa stała się odpowiedź na to, dlaczego przejście od niekontrolowanego Shadow AI do policzalnych, bezpiecznych projektów jest tak trudne. Problem ten był podczas Forum analizowany z różnych perspektyw: od strategicznych dylematów w salach zarządów, przez realia cyberbezpieczeństwa na froncie, aż po szczere rozmowy o technicznych bolączkach AI.

Globalna wizja – „AI podąża za danymi”

Energią na głównej scenie można by obdzielić kilka mniejszych konferencji. Dariusz Piotrowski, VP i Dyrektor Zarządzający Dell Technologies Polska, otwierając tegoroczne forum, nie ukrywał dumy. „Przygotowujemy się do tego dnia przez cały rok. To nasze święto” – mówił, witając rekordową, niemal 3-tysięczną publiczność.

Po tym energicznym wstępie, światła przygasły, a na ekranie pojawił się Michael Dell. Jego wirtualne wystąpienie było jak spojrzenie z lotu ptaka: globalne, spokojne i nakreślone grubą kreską. Przekaz był jasny: rewolucja już się wydarzyła. „Wkrótce ponad 75% danych firmowych będzie przetwarzanych na brzegu sieci (edge)” – zaznaczył, dodając, że nie jest to już wizja, lecz fakt: „Dziś ponad 3000 klientów korzysta z fabryk AI Della (Dell AI factories)”.

Dyskusja nabrała praktycznego wymiaru, gdy na scenę wrócił Dariusz Piotrowski, by odnieść globalną wizję do lokalnego kontekstu. Zdecydował się na szybką ankietę wśród publiczności: „Ile osób na sali na co dzień korzysta z rozwiązań AI (…) i na podstawie informacji z nich podejmuje decyzję?”. Znacząca liczba podniesionych rąk posłużyła za punkt wyjścia do kluczowej diagnozy. Piotrowski, choć skomentował frekwencję żartem, zaraz po tym przeszedł do meritum. Wskazał, że w większości przypadków ta powszechna aktywność to nie są oficjalne projekty firmowe, ale zjawisko, które można nazwać Shadow AI.

I tu dotarliśmy do sedna. „Mówiliśmy, że technologia zmienia świat. Dziś mówimy: AI zmienia świat” – zaczął. „Natomiast prawda jest taka, że AI zmienia tylko to, do czego ma dostęp. A dostęp ma do danych”.

Chwilę później padło zdanie-klucz, które stało się mantrą całego forum: „AI podąża za danymi, nie odwrotnie”.

Piotrowski nie zamiatał problemów pod dywan. Bez ogródek przytoczył dane (McKinsey, IDC), z których wynika, że tylko 10% projektów AI realnie generuje zyski, a wiele z nich upadnie. Diagnoza była brutalna, ale szczera: problemem nie jest brak talentów czy algorytmów. Problemem jest chaos. „Sukces odniosły te firmy, które potrafiły uporządkować dane i swoje procesy” – stwierdził.

“Jak?” – pragmatyczny plan działania

Podczas gdy wizja wyznacza strategiczny horyzont, o realnym sukcesie decyduje pragmatyzm i skuteczność wdrożenia. Tę kluczową perspektywę wykonawczą przedstawił Said Akar, Senior Vice President w Dell Technologies. Jego wystąpienie odpowiadało na fundamentalne pytanie „jak?” – jak przekształcić ambitne idee w działający, przynoszący zyski proces?

Zanim jednak Said Akar przedstawił swoją koncepcję „Fabryki AI”, rozpoczął od najbardziej przekonującego dowodu jej skuteczności. Jako kluczowe studium przypadku udanej transformacji AI posłużył się… samą firmą Dell.

Punktem kulminacyjnym tej analizy były twarde dane finansowe. „W zeszłym roku dodaliśmy 10 miliardów dolarów przychodu. I zrobiliśmy to, jednocześnie zmniejszając koszty o 4%” – oznajmił. By w pełni wybrzmiał sens tych liczb, Akar dodał kluczowe wyjaśnienie. Podkreślił, że był to historyczny moment dla firmy – po raz pierwszy udało się „odseparować wzrost przychodów od wzrostu kosztów”. Przez dekady, wzrost przychodów nieuchronnie oznaczał także wzrost kosztów operacyjnych. Wdrożenie AI, jak dowodził, pozwoliło firmie obsłużyć ten dodatkowy wolumen biznesu, jednocześnie redukując koszty. Dla sali pełnej menedżerów był to najmocniejszy dowód, że transformacja AI nie jest kosztem, lecz policzalną inwestycją.

Tym, co miało umożliwić ten sukces, jest Dell AI Factory – Fabryka AI. Akar opisywał ją jako „plan” dla organizacji, które nie wiedzą, od czego zacząć.

Co ciekawe, ten plan wcale nie zaczyna się od pytania „jaki serwer kupić?”. Zaczyna się od przypadku użycia (use case). Akar zdradził, że gdy Dell rozpoczynał swoją podróż, miał 1800 oddolnych pomysłów na AI, co potencjalnie mogło doprowadzić do “totalnego chaosu”. Zmienili więc podejście na odgórne, stawiając żelazną zasadę: „Nie będziemy inwestować naszego czasu, wysiłku, jeśli nie możemy zmierzyć zwrotu z inwestycji (ROI)”.

Jako przykład podał wewnętrzne narzędzie „Dell Sales Chat”. Zespół wdrożył je w zaledwie cztery miesiące. Brzmi świetnie? Tu właśnie kryje się haczyk, o którym mówił już Piotrowski. Największym wyzwaniem nie był algorytm. „Zajęło nam, firmie zajmującej się danymi, cztery miesiące, aby to wszystko zebrać w całość” – przyznał Akar, podkreślając, że uporządkowanie danych było największym wyzwaniem projektu.

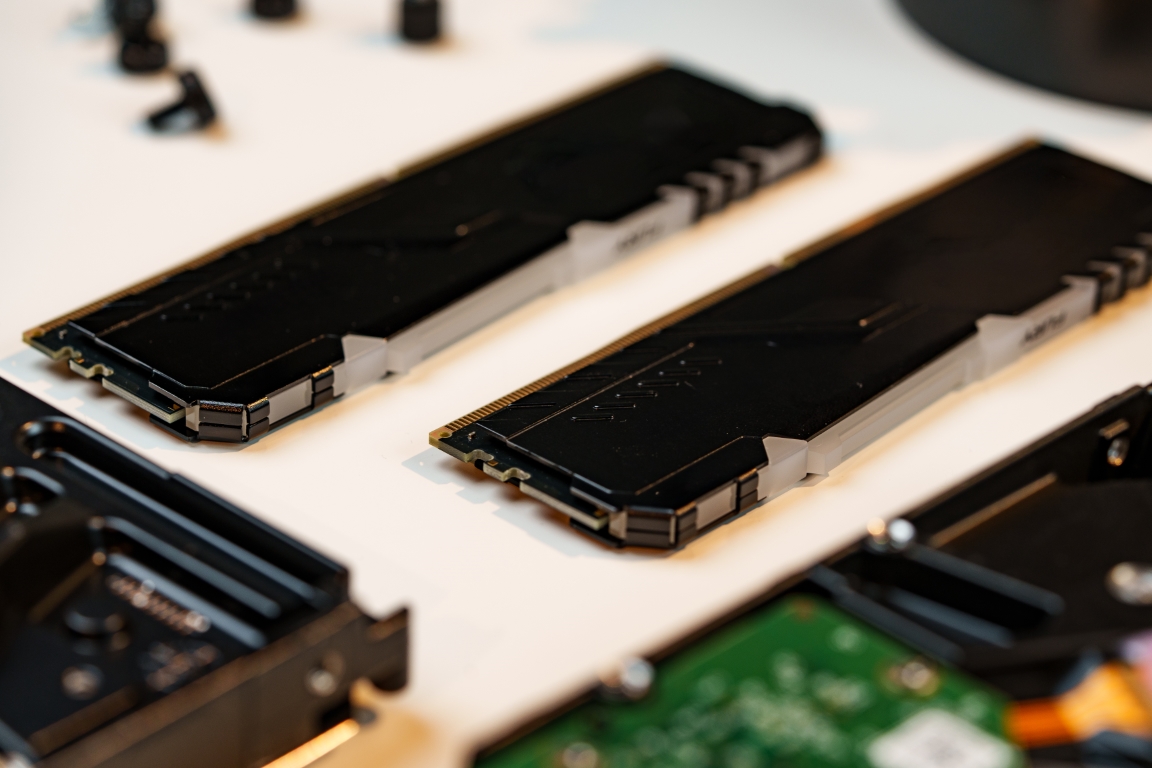

„Fabryka AI” to także obalenie kilku mitów. Po pierwsze, to gra zespołowa – Dell mocno akcentuje swój ekosystem partnerów (Nvidia, Intel, Microsoft, Meta). Po drugie, chmura publiczna nie jest jedyną odpowiedzią. Akar przytoczył dane, wg których 62% respondentów uważa uruchomienie AI lokalnie (on-prem) za bardziej opłacalne. AI jest „głodne wydajności” i musi być blisko danych, co idealnie spina się z wizją Edge Computingu z pierwszej prezentacji.

Na koniec padła ważna uwaga dla tych, którzy boją się kosztów. Infrastruktura AI nie musi oznaczać budowy superkomputera od zera. Akar podkreślał znaczenie „odpowiedniego zwymiarowania” (right-sizing): „Można zacząć od małej i zacząć stopniowo rosnąć”. Rewolucję można więc zacząć metodą małych kroków.

AI po polsku – debata o zaufaniu i konkurencji

Sesją, która najmocniej osadziła dyskusję w polskich realiach, był panel „AI.Po prostu. Praktyka i realna transformacja w Polsce”. Sala dyskusyjna wypełniła się publicznością, co nie było zaskoczeniem, biorąc pod uwagę skład gości. Obok moderatora Roberta Domagały (Dell) i Dariusza Piotrowskiego (Dell), na scenie zasiedli Radosław Maćkiewicz (CEO Centralnego Ośrodka Informatyki), Zbigniew Jagiełło (innowator i twórca Blika) oraz Sebastian Kondracki (Chief Innovation Officer Deviniti i ojciec chrzestny projektu SpeakLeash).

Radosław Maćkiewicz opowiadał o gigantycznym kapitale, jakim dysponuje państwo – zaufaniu 11 milionów użytkowników aplikacji mObywatel. Na tym fundamencie COI buduje teraz wirtualnego asystenta, który ma pomagać obywatelom. I tu padła kluczowa deklaracja: sercem systemu będzie PLLuM, czyli polski model językowy trenowany specjalnie dla administracji. Jak barwnie ujął to Maćkiewicz, nie będzie to model, który „poda przepis na szarlotkę”, ale taki, który precyzyjnie poprowadzi przez meandry spraw urzędowych.

Początkowo spokojną dyskusję ożywił Zbigniew Jagiełło, który zadał panelistom bezpośrednie pytanie o sens istnienia dwóch oddzielnych, dużych polskich modeli językowych: „Dlaczego nie połączycie sił? Czy Polska jest tak silna (…), że i PLLuM i Bielik mogą się rozwijać osobno?”.

Pytanie to wywołało dyskusję, która wyraźnie zarysowała różnice w podejściu do rozwoju AI w Polsce. Sebastian Kondracki, reprezentujący open-source’owego Bielika, bronił wartości konkurencji, powołując się na pojęcie stworzone przez Marka Magrysia z Cyfronetu, instytucji wspierajacej oba modele – “kopetycja”, czyli połączenie współpracy z konkurencją. “Współpracujemy, wymieniamy się informacjami, ale mały element rywalizacji nie zaszkodzi” Podkreślał przy tym, że celem Bielika nie jest ściganie się z OpenAI, ale to, „żeby Polska była specjalistą w specjalizowanych modelach lub niszowych modelach”.

W podobnym tonie wypowiadał się Radosław Maćkiewicz, który zaznaczył, że państwowy PLLuM jest trenowany właśnie do takich specjalistycznych zadań – nie ma „podawać przepisu na szarlotkę”, lecz precyzyjnie wspierać obywatela w sprawach urzędowych.

Głos w dyskusji zabrał również Dariusz Piotrowski, który zasugerował, że być może Polska nie potrzebuje jednego „ChatGPT”, ale właśnie wielu wyspecjalizowanych modeli, dedykowanych dla konkretnych branż, jak energetyka czy medycyna. Debata wyraźnie pokazała więc, że na polskiej scenie AI ścierają się różne wizje – od strategicznych projektów państwowych, przez konkurencyjne modele open-source, po ideę rozproszonej, branżowej specjalizacji.

AI na linii frontu i w sali zarządu

Kolejnym kluczowym tematem poruszonym na forum, po intensywnej dyskusji o polskich modelach AI, było bezpieczeństwo. To fundamentalne zagadnienie omówiono w dwóch kontekstach: cyberbezpieczeństwa w wymiarze militarnym oraz zarządzania ryzykiem na poziomie strategicznym w przedsiębiorstwach.

Szczególnym zainteresowaniem cieszył się fireside chat z udziałem gen. dyw. Karola Molendy, Dowódcy Komponentu Wojsk Obrony Cyberprzestrzeni. Prowadzący rozmowę Dariusz Piotrowski zauważył, że generał z dużą swobodą łączy perspektywę militarną z biznesową, co znalazło potwierdzenie w prezentacji innowacyjnego podejścia armii do cyberbezpieczeństwa. Generał Molenda szczegółowo omówił projekt „Cyber Legion” – inicjatywę mającą na celu integrację cywilnych specjalistów z wojskowymi ekspertami. O sukcesie tego przedsięwzięcia świadczy fakt, iż do tej pory zgromadziło ono ponad 2500 chętnych.

Generał Molenda wskazał na fundamentalną zmianę paradygmatu w działaniu armii jako kluczowy element nowoczesnej cyberobrony. Wyjaśnił, że jednostka odeszła od restrykcyjnej zasady „need to know” (wiedzieć tylko to, co konieczne) na rzecz otwartej strategii „need to share”. Podkreślił, że w domenie cyberbezpieczeństwa zdolność do szybkiego dzielenia się informacją jest kluczowa dla skuteczności działań.

W tym kontekście omówił rolę sztucznej inteligencji, która ewoluowała od pasywnego monitoringu do aktywnego narzędzia wsparcia. Generał określił AI jako technologię o przełomowym znaczeniu („game changer”), która umożliwia analizę danych rozpoznawczych na niespotykaną dotąd skalę i wspiera procesy decyzyjne. Jako przykład podał zdolność systemów do kalkulowania prawdopodobieństwa sukcesu operacji w czasie rzeczywistym, w oparciu o konkretne rozkazy i zmienne warunki.

Równie strategiczny wymiar miała dyskusja podczas panelu „AI w zarządzie: rewolucja czy kontrolowany eksperyment?”, realizowana w ramach Executive Business Lounge. Liderzy biznesu (Orange, mBank) i nauki (Cambridge) mierzyli się z kluczowymi wyzwaniami: Jak zarządzać innowacją i ryzykiem, gdy pracownicy już teraz masowo korzystają z nieuregulowanych narzędzi (tzw. „Shadow AI”)?

Dr Paul Calleja, dyrektor Cambridge Open Zettascale Lab, przedstawił perspektywę świata nauki i R&D. Zdiagnozował, że korporacje „nadrabiają zaległości”, próbując regulować technologię, która rozwija się zbyt szybko. Wskazał na zjawisko „dwóch żyć IT” – korporacyjnego, zablokowanego, oraz prywatnego, w którym pracownicy swobodnie korzystają z ChatGPT. Jego zdaniem, blokowanie narzędzi jest nieskuteczne. Kluczowym rozwiązaniem staje się edukacja: „Musimy uczyć ludzi krytycznego myślenia i myślenia analitycznego”, ponieważ, jak trafnie zauważył, modele AI są często trenowane, by „brzmieć przekonująco”, a niekoniecznie mówić prawdę.

Praktyczną odpowiedź na ten postulat przedstawiła Bożena Leśniewska (Orange Polska). Opisała, jak jej firma, zamiast blokować narzędzia, postawiła na „kontrolowaną demokratyzację” – stworzono ustrukturyzowany proces dla oddolnych inicjatyw. Efektem było „250 różnych przypadków użycia, które zostały przełożone na rzeczywiste przypadki biznesowe”. Podkreśliła, że fundamentem tego sukcesu jest właśnie masowa edukacja, obejmująca ponad 5000 pracowników przeszkolonych m.in. z odpowiedzialnego AI (Responsible AI).

Perspektywę sektora bankowego, skupioną na zarządzaniu ryzykiem, wniosła Agnieszka Słomka-Gołębiowska (mBank). Przyznała, że banki przechodzą od analityki (np. obsługa reklamacji) do predykcji (proaktywne wykrywanie nadużyć). Wskazała jednak, że kluczowym wyzwaniem pozostaje stronniczość algorytmów (bias). Tu padła fundamentalna przestroga dla całej branży: „Największym ryzykiem byłaby stronniczość. (…) Banki działają w biznesie zaufania. To jest to, co zapewniamy naszym klientom”. Jak podkreśliła, zaufanie jest cenniejsze niż jakakolwiek optymalizacja, a AI nie może stać się narzędziem manipulacji.

Całą tę strategiczną i niezwykle wartościową dyskusję celnie podsumował Mohammed Amin z Della, dając menedżerom prostą radę: „Think big, start small” (Myśl globalnie, zaczynaj lokalnie).

Od „Edge” po walkę z halucynacjami

Technicznym dopełnieniem strategicznych dyskusji była prezentacja Wojtka Janusza, Data Science and AI Lead w Dell Technologies. Janusz, pełniący w firmie rolę „tłumacza” między biznesem a inżynierami, przedstawił kluczowe wyzwania technologiczne stojące obecnie przed branżą.

Potwierdził on rosnące znaczenie trendu „AI on the Edge”, o którym mówili wcześniej Piotrowski i Akar. Chodzi o zdolność do uruchamiania potężnych modeli AI lokalnie, na laptopach, co – jak przyznał Janusz – „było zupełnie nie do zdziałania jeszcze dwa lata temu”, a dziś staje się codziennością.

Następnie Janusz wprost odniósł się do największej bolączki obecnych modeli, nazywając halucynacje „obecnym problemem nr 1 całej branży”. Wyjaśnił, że wszyscy giganci rynku dużych modeli językowych skupiają dziś swoje wysiłki właśnie na walce z konfabulacją algorytmów. Kluczem ma być fundamentalna zmiana filozofii treningu: zamiast nagradzać model za odpowiedź, która ma „zadowolić człowieka” (nawet jeśli jest zmyślona), nowy paradygmat zakłada karanie za improwizację. „Teraz zmieniamy ten paradygmat i mówimy: jak nie wiesz, to powiedz, że nie wiesz” – wyjaśnił Janusz.

To szczere postawienie sprawy idealnie podsumowało całe Dell Technologies Forum. Czasy „magicznego AI”, które zastąpi człowieka, wydają się odchodzić do lamusa („To się nie wydarzyło i się nie wydarzy” – kwitował Janusz). Zastępuje ją koncepcja „Fabryki AI”, w której technologia ma przejąć „niewdzięczne zadania” rzeczy, których nie lubimy robić, ale to człowiek, w ramach pętli „human in the loop”, wciąż podejmuje ostateczną decyzję. Forum pokazało, jak zbudować taką fabrykę. Ale to od nas zależy, kto w niej będzie pociągał za dźwignie.

Opuściłam tegoroczne Dell Technologies Forum z jednym, dominującym odczuciem: to koniec „magii”, a początek ery dojrzałej inżynierii. Po latach, w których dominował szum i obawy przed „Shadow AI”, dyskusja nareszcie przeniosła się na właściwe tory. Prawdziwymi bohaterami konferencji nie były algorytmy, lecz twarde dane (jak 10 mld przychodu Della), pragmatyzm (walka z halucynacjami) i odpowiedzialność (od zaufania w mBanku po cyberfront generała Molendy).

Jako redakcja Brandsit byliśmy patronem medialnym tego wydarzenia.