W styczniu 2024 roku pracownik działu finansowego w międzynarodowej firmie inżynieryjnej Arup otrzymał wiadomość e-mail, która wydawała się pochodzić od dyrektora finansowego (CFO) z brytyjskiej centrali. E-mail informował o tajnej transakcji i zawierał zaproszenie na wideokonferencję. Pracownik, choć początkowo podejrzliwy, dołączył do rozmowy. Po drugiej stronie ekranu zobaczył nie tylko CFO, ale także kilku innych znanych mu członków zarządu. Ich wygląd i głosy były idealnie odwzorowane. Przekonany o autentyczności spotkania, w ciągu następnych dni autoryzował 15 przelewów na łączną kwotę 25,6 miliona dolarów. Dopiero po fakcie odkrył, że padł ofiarą jednego z najbardziej zuchwałych oszustw w historii. Wszyscy uczestnicy wideokonferencji byli cyfrowymi klonami, wygenerowanymi przez sztuczną inteligencję.

Ten incydent to nie scenariusz filmu science fiction, ale brutalna rzeczywistość nowej ery cyberzagrożeń. Witamy w świecie Phishing 2.0 – ewolucji phishingu, która dzięki sztucznej inteligencji, uczeniu maszynowemu i technologii deepfake stała się bardziej wyrafinowana, spersonalizowana i niebezpieczna niż kiedykolwiek wcześniej. Tradycyjne ataki, które przez lata uczyliśmy się rozpoznawać po błędach gramatycznych i ogólnikowych zwrotach, odchodzą do lamusa. Ich miejsce zajmują kampanie niemal nieodróżnialne od autentycznej komunikacji, precyzyjnie wymierzone w konkretne osoby i zdolne do omijania tradycyjnych zabezpieczeń.

Sztuczna inteligencja nie jest już tylko narzędziem, które usprawnia phishing; ona fundamentalnie go redefiniuje. Demokratyzuje dostęp do zaawansowanych technik ataku, które kiedyś były domeną jedynie wyspecjalizowanych grup hakerskich, i napędza wyścig zbrojeń w cyberprzestrzeni. W tej nowej rzeczywistości zarówno atakujący, jak i obrońcy, toczą bitwę na algorytmy, w której stawką są dane, finanse i zaufanie stanowiące fundament cyfrowej gospodarki.

| Cecha | Phishing 1.0 (Przed erą AI) | Phishing 2.0 (Wspierany przez AI) |

|---|---|---|

| Język i gramatyka | Częste błędy, nienaturalne sformułowania. | Perfekcyjna gramatyka, imitacja stylu pisania konkretnych osób. |

| Personalizacja | Ogólnikowe zwroty typu „Drogi Kliencie”. | Hiperpersonalizacja z wykorzystaniem danych z mediów społecznościowych i rejestrów publicznych. |

| Skala i szybkość | Kampanie manualne, ograniczone zasobami. | Zautomatyzowane generowanie tysięcy unikalnych wiadomości w kilka minut. |

| Wektory ataku | Głównie poczta e-mail. | Wielokanałowość: e-mail, SMS (smishing), połączenia głosowe (vishing), media społecznościowe. |

| Taktyki unikania | Proste podszywanie się pod domeny. | Dynamiczne klonowanie stron, zaciemnianie kodu przez AI, deepfake audio i wideo. |

| Wymagane umiejętności | Podstawowa wiedza techniczna. | Niski próg wejścia dzięki narzędziom AI i platformom Phishing-as-a-Service (PhaaS). |

Anatomia ataku Phishing 2.0: Arsenał napędzany przez AI

Nowoczesny atak phishingowy to złożony, wieloetapowy proces, w którym sztuczna inteligencja odgrywa kluczową rolę na każdym kroku. U podstaw Phishing 2.0 leżą duże modele językowe (LLM), takie jak GPT-4, a także ich nieocenzurowane, dostępne w darknecie odpowiedniki, jak WormGPT czy FraudGPT. Te narzędzia stały się dla cyberprzestępców niewyczerpanym źródłem perfekcyjnie napisanych, psychologicznie przekonujących treści. Eliminują błędy gramatyczne, naśladują styl komunikacji konkretnych osób i potrafią tworzyć perswazyjne narracje na podstawie zaledwie kilku prostych poleceń.

Skuteczność Phishing 2.0 opiera się na hiperpersonalizacji, a ta zależy od jakości zebranych danych. Sztuczna inteligencja zautomatyzowała proces rekonesansu (OSINT), systematycznie przeszukując cyfrowy ślad potencjalnych ofiar. Algorytmy AI agregują informacje z mediów społecznościowych, stron korporacyjnych i publicznych rejestrów, aby poznać zainteresowania, relacje zawodowe i ostatnie aktywności ofiary. Zebrane dane – nazwa projektu, imię przełożonego, czy niedawne wakacje – są wplatane w treść wiadomości, co sprawia, że oszustwo wydaje się niezwykle autentyczne.

Sztuczna inteligencja umożliwiła również masową produkcję i dystrybucję ataków. Powstały platformy „Phishing-as-a-Service” (PhaaS), takie jak „SpamGPT”, które naśladują interfejs legalnych usług marketingowych, ale służą celom przestępczym. Oferują one zintegrowanego asystenta AI do generowania szablonów, automatyzację wysyłki i śledzenie analityki, co pozwala nawet osobom o niewielkich umiejętnościach technicznych prowadzić zaawansowane operacje na dużą skalę.

Jednym z największych wyzwań jest zdolność Phishing 2.0 do omijania tradycyjnych filtrów bezpieczeństwa. AI jest tu wykorzystywana do tworzenia dynamicznych zagrożeń. Narzędzia AI potrafią tworzyć idealne, aktualizowane w czasie rzeczywistym repliki legalnych stron logowania. Analitycy z Microsoft Threat Intelligence zidentyfikowali kampanię, w której AI posłużyło do ukrycia złośliwego kodu wewnątrz pliku graficznego, maskując go przy użyciu terminologii biznesowej, aby zmylić skanery. Przestępcy nadużywają też zaufanych platform deweloperskich do hostowania fałszywych stron z weryfikacją CAPTCHA, która blokuje automatyczne skanery, ale przepuszcza ofiarę do strony wyłudzającej dane.

Integracja AI z phishingiem to industrializacja cyberprzestępczości. Obserwujemy przejście od modelu „rzemieślniczego” do „przemysłowego”. AI stało się linią produkcyjną, która automatyzuje cały proces ataku na skalę wcześniej nieosiągalną.

Element ludzki pod oblężeniem: Deepfake i manipulacja psychologiczna

Najbardziej niepokojącym frontem ewolucji phishingu jest wykorzystanie AI do tworzenia hiperrealistycznych imitacji głosu i obrazu. Technologia deepfake uderza w zaufanie do własnych zmysłów. Do stworzenia przekonującej imitacji głosu wystarczy zaledwie kilka sekund materiału audio. Atakujący wykorzystują tę technologię w wiadomościach głosowych lub w czasie rzeczywistym podczas rozmów telefonicznych (vishing).

Analiza rzeczywistych incydentów pokazuje niszczycielski potencjał tej technologii. W przypadku firmy Arup, pracownik, który początkowo podejrzewał phishing, został całkowicie przekonany po wideokonferencji z cyfrowymi klonami zarządu. W innym ataku, prezes brytyjskiej firmy energetycznej autoryzował przelew na 243 000 dolarów po rozmowie telefonicznej z sklonowanym głosem swojego przełożonego.

Jednak istnieją również przykłady udaremnionych prób, które dostarczają cennych lekcji. Atak na Ferrari został powstrzymany, gdy menedżer zadał rzekomemu CEO pytanie kontrolne o niedawną, prywatną rozmowę, na które AI nie potrafiło odpowiedzieć. W firmie Wiz próba oszustwa nie powiodła się, ponieważ pracownicy zauważyli subtelną różnicę między głosem CEO z publicznych wystąpień (na którym trenowano AI) a jego tonem w codziennych rozmowach. Z kolei pracownik LastPass zignorował próbę kontaktu od rzekomego CEO, ponieważ odbywała się ona przez nietypowy kanał (WhatsApp) i poza standardowymi godzinami pracy.

Te przypadki ujawniają fundamentalną słabość technologii deepfake: „lukę kontekstową”. AI potrafi replikować wzorce, ale nie potrafi replikować autentycznego, wspólnego ludzkiego doświadczenia. Nie zna treści prywatnych rozmów ani subtelnych niuansów interakcji. Ta luka jest nowym polem bitwy, na którym „ludzki firewall” może odnieść zwycięstwo.

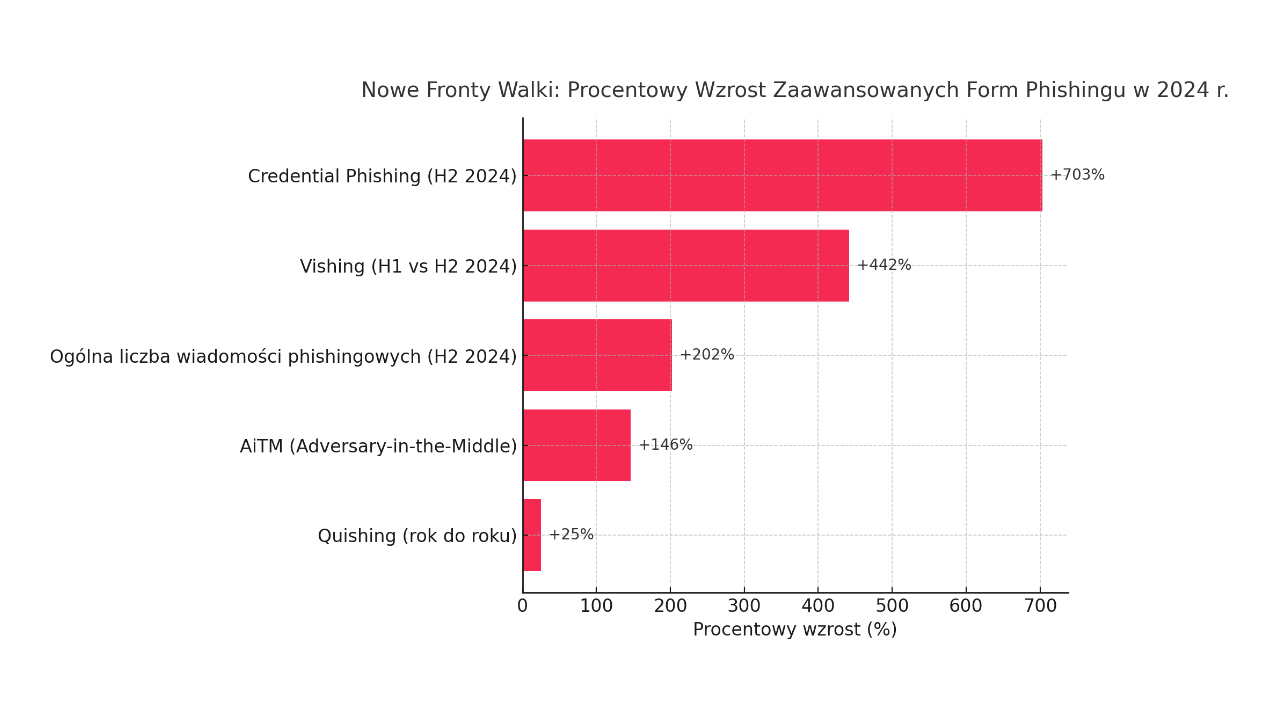

Dane stojące za zagrożeniem: Kwantyfikacja wpływu

Skala transformacji znajduje odzwierciedlenie w twardych danych. Raporty wskazują na wzrost liczby e-maili phishingowych o 1,265%, bezpośrednio wiążąc go z upowszechnieniem się technologii GenAI. Całkowity wolumen phishingu wzrósł o 4,151% od debiutu ChatGPT.

Wzrost liczby ataków przekłada się na rosnące straty finansowe. Średni koszt naruszenia danych, którego wektorem był phishing, osiągnął w 2024 roku poziom 4,8 miliona dolarów. Straty wynikające z ataków typu Business Email Compromise (BEC) osiągnęły rekordową sumę 2,9 miliarda dolarów.

Co więcej, eksperyment przeprowadzony przez firmę Hoxhunt wykazał, że w marcu 2025 roku agent AI stał się o 24% bardziej skuteczny w tworzeniu kampanii phishingowych niż elitarny, ludzki zespół ekspertów. To dowodzi, że sztuczna inteligencja staje się obiektywnie lepsza w manipulowaniu ludźmi.

Chociaż ogólny wolumen ataków rośnie, obserwuje się również strategiczną zmianę. Atakujący coraz częściej odchodzą od masowych kampanii na rzecz precyzyjnie ukierunkowanych operacji na działy o wysokim znaczeniu, takie jak finanse czy HR. Niezmiennie najczęściej podszywaną marką pozostaje Microsoft, wykorzystywany w ponad 51,7% oszustw.

Walka ogniem z ogniem: Obrona napędzana przez AI

W odpowiedzi na zagrożenia, branża cyberbezpieczeństwa również sięgnęła po AI, tworząc nową generację inteligentnych systemów obronnych. W przeciwieństwie do tradycyjnych filtrów, defensywna AI jest adaptacyjna i kontekstowa. Jej działanie opiera się na analizie behawioralnej, tworząc dynamiczny profil normalnych wzorców komunikacji i wykrywając anomalie, takie jak nagła zmiana tonu w e-mailu od znanego nadawcy. Narzędzia przetwarzania języka naturalnego (NLP) analizują treść wiadomości pod kątem subtelnych sygnałów manipulacji.

Sztuczna inteligencja rewolucjonizuje również pracę zespołów ds. bezpieczeństwa (SOC), automatyzując analizę logów i klasyfikację alertów, co pozwala ludzkim analitykom skupić się na najbardziej złożonych incydentach. Co ciekawe, te same duże modele językowe, które służą do tworzenia phishingu, okazują się również skuteczne w jego wykrywaniu.

Ta ewolucja wymusza fundamentalną zmianę filozofii w cyberbezpieczeństwie. Obserwujemy przejście od modelu opartego na „stanie” (czy ten element jest znany jako zły?) do modelu opartego na „zachowaniu” (czy ten element zachowuje się dziwnie?). Nowy model, napędzany przez AI, nie interesuje się tyle „co to jest”, ile „jak to działa”.

Budowanie odpornej organizacji: Wielowarstwowa strategia

Skuteczna obrona wymaga zintegrowanego podejścia, które łączy technologię, procesy i świadomego człowieka. Tradycyjne szkolenia przestały być wystarczające. Nowy program musi przygotować pracowników na konfrontację z deepfake’ami. Kluczowe staje się wdrożenie protokołów weryfikacji pozapasmowej dla każdej wrażliwej prośby – potwierdzenie e-maila telefonem na znany numer. Przykład Ferrari pokazuje też siłę prostych pytań bezpieczeństwa opartych na wspólnym, prywatnym kontekście.

Technologia musi stanowić solidny fundament. Filozofia Zero Trust („nigdy nie ufaj, zawsze weryfikuj”) staje się podstawową strategią obronną. Niezbędne jest też uwierzytelnianie wieloskładnikowe (MFA) odporne na phishing, oparte na standardach FIDO2 (np. klucze sprzętowe), które wiążą proces uwierzytelniania z fizycznym tokenem, czyniąc skradzione hasło bezużytecznym.

Prognozy analityków, takich jak Gartner, wskazują na zmianę w alokacji budżetów. Do 2030 roku ponad połowa wydatków będzie przeznaczana na środki prewencyjne, a nie na reakcję po incydencie. Jest to przyznanie, że tradycyjne modele są zbyt wolne, aby zwalczać ataki z prędkością AI.

Najskuteczniejsze mechanizmy obronne nie są już czysto techniczne; są zintegrowane z procesami biznesowymi. Porażka w Arup była porażką procesową – w procedurze finansowej brakowało obowiązkowego, niedygitalnego kroku weryfikacyjnego. Z kolei sukces Ferrari był sukcesem procesowym. Rozwiązanie wymaga zmiany sposobu wykonywania pracy. Liderzy IT muszą stać się inżynierami procesów biznesowych, wbudowując kroki weryfikacji bezpośrednio w przepływy pracy o wysokim ryzyku.

Nawigacja w przyszłości cyfrowego oszustwa

Phishing 2.0, napędzany przez AI, nie jest hipotetycznym zagrożeniem, ale obecną rzeczywistością. Jest bardziej spersonalizowany, przekonujący i działa na skalę przemysłową. Technologia deepfake podważyła nasze fundamentalne zaufanie do dowodów zmysłowych.

Stoimy w obliczu nowej ery, w której AI zdemokratyzowało zaawansowane ataki, a obrona musi być równie inteligentna. Patrząc w przyszłość, eksperci przewidują dalszą eskalację tego wyścigu zbrojeń. Mówi się o powstaniu autonomicznych, wieloagentowych systemów AI („rojów agentów”), które będą prowadzić złożone operacje zarówno po stronie ataku, jak i obrony. Brytyjskie Narodowe Centrum Cyberbezpieczeństwa (NCSC) prognozuje, że AI będzie nadal skracać czas między ujawnieniem luki a jej wykorzystaniem.

Odporność jest hybrydą inteligentnej technologii i równie inteligentnej, sceptycznej siły roboczej. Ostateczną obroną jest holistyczna strategia, która łączy predykcyjną moc AI z kontekstową mądrością dobrze wyszkolonego, działającego zgodnie z procedurami zespołu ludzkiego. Walka z cyfrowym oszustwem weszła na nowy poziom, a nasza zdolność do adaptacji zadecyduje o jej wyniku.