Przyjęło się uważać, że najgorsze awarie to te spowodowane atakami DDoS lub katastrofalnymi błędami w logice biznesowej. Jednak wydarzenia z 18 listopada 2025 roku w Cloudflare przypomniały nam o znacznie bardziej podstępnym wrogu: rutynie, która budzi uśpione błędy.

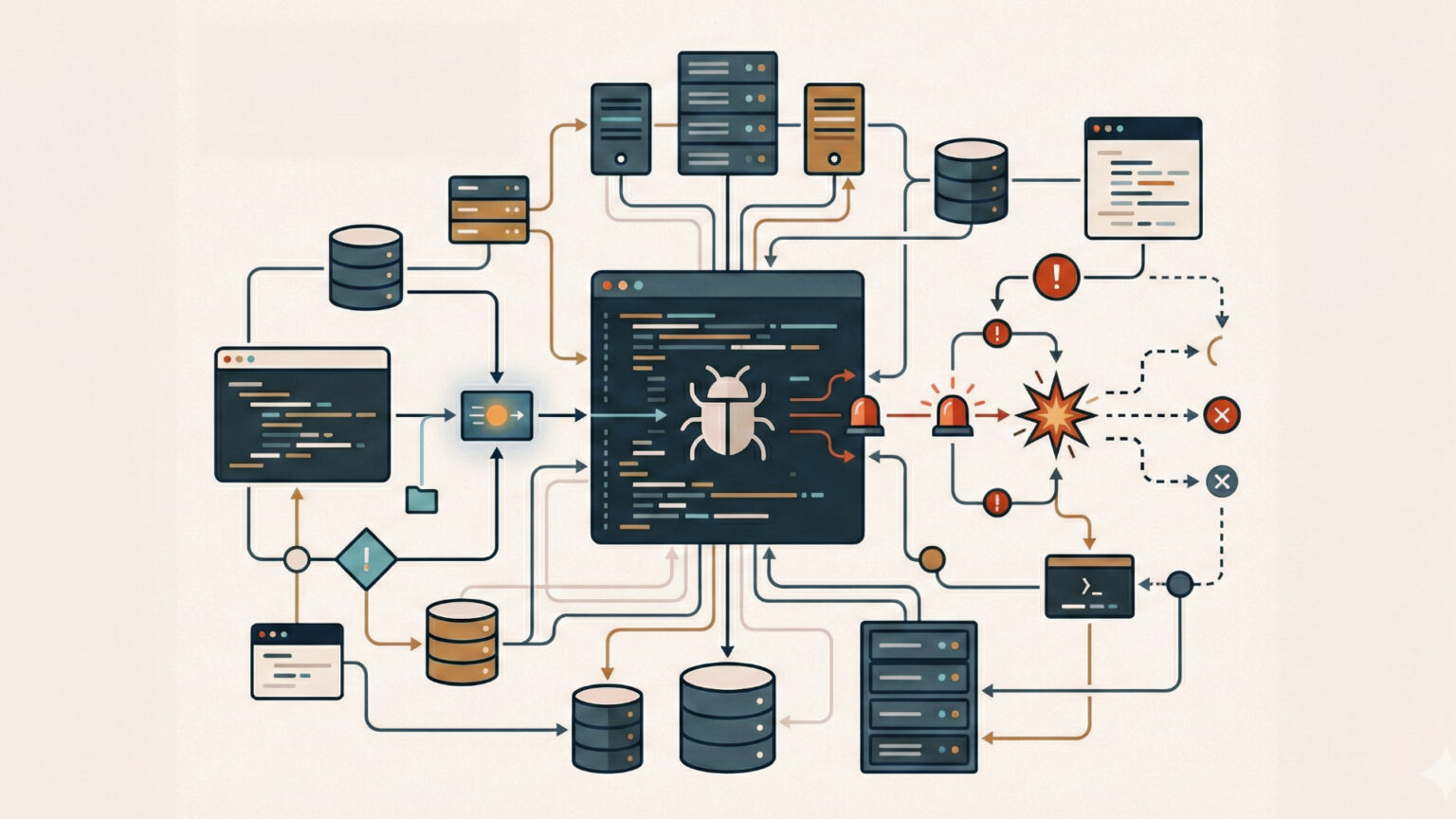

Każdy, kto zarządza systemami rozproszonymi, zna ten scenariusz: wszystko działa zgodnie z planem, testy przechodzą na zielono, a wdrożenie wydaje się formalnością. A jednak, chwilę później dashboardy świecą na czerwono. Analiza incydentu, który dotknął jedną z kluczowych usług internetowych, to nie tylko kronika wydarzeń, ale przede wszystkim fascynujące studium przypadku dla inżynierów SRE i DevOps. Przenosi ono ciężar dyskusji z „jak naprawić” na znacznie trudniejsze pytanie: „jak wykryć coś, co teoretycznie nie istnieje?”.

Uśpiony wróg w kodzie (Latent Bug)

Eksperci analizujący ten przypadek zwracają uwagę na koncepcję „błędu utajonego” (ang. latent bug). To fragment kodu, który w normalnych warunkach jest całkowicie niegroźny. Śpi, czekając na specyficzny, rzadki splot wydarzeń.

W omawianym przypadku mechanizm był wręcz podręcznikowy. Z jednej strony mieliśmy sztywny limit w kodzie Rust (maksymalnie $200$ funkcji w konfiguracji), zaprojektowany jako optymalizacja wydajności. Z drugiej – rutynową zmianę w bazie danych ClickHouse, która niespodziewanie zwróciła zduplikowane metadane. Wynik? Plik konfiguracyjny spuchł dwukrotnie, przekraczając limit, o którego istnieniu system „zapomniał”, bo nigdy wcześniej nie był testowany w warunkach brzegowych.

To prowadzi do paniki systemu (słynne `unwrap()` na błędzie) i kaskadowej awarii. Lekcja jest brutalna: optymalizacja wydajności, która nie jest zabezpieczona logiką odporności, staje się długiem technicznym.

Obserwowalność to nie tylko logi błędów

Wnioski płynące z tego zdarzenia redefiniują podejście do monitoringu. Tradycyjne czekanie na kody HTTP 500 to za mało. Jak słusznie zauważają specjaliści zajmujący się niezawodnością, kluczem jest proaktywność oparta na metrykach nasycenia.

Oto co inżynierowie powinni wdrożyć „na wczoraj”, by uniknąć podobnych scenariuszy:

Monitoring limitów „sztywnych”: Jeśli system ma zaszyty limit (np. wielkość bufora czy liczba wpisów), monitoring musi alarmować, gdy zbliżamy się do niego na 80%, a nie dopiero po jego przekroczeniu. To klasyczne wykorzystanie jednego z „Czterech Złotych Sygnałów” (Saturation).

Korelacja wdrożeń z anomaliami: Awaria była bezpośrednim skutkiem zmiany. Nowoczesne systemy obserwowalności muszą automatycznie wiązać „panikę” aplikacji z ostatnim zdarzeniem w pipeline CI/CD. Skraca to czas MTTI (Mean Time To Identify) z godzin do minut.

Kanarki sprawdzające strukturę danych: Testy syntetyczne nie powinny sprawdzać tylko czy usługa „wstaje”, ale czy dane, które generuje (np. pliki konfiguracyjne), mieszczą się w normach bezpieczeństwa przed ich globalną propagacją.

Architektura nieufnocści

Analiza tego przypadku prowadzi do jeszcze jednego, fundamentalnego wniosku architektonicznego: nie ufaj własnym konfiguracjom.

Często traktujemy dane wejściowe od użytkowników jako potencjalnie niebezpieczne (SQL Injection, XSS), ale pliki konfiguracyjne generowane przez nasze własne systemy uznajemy za bezpieczne. To błąd. Podejście Input Hardening sugeruje, by wewnętrzne konfiguracje walidować z taką samą rygorystycznością, co dane zewnętrzne. Gdyby system sprawdził rozmiar pliku przed próbą jego przetworzenia, skończyłoby się na odrzuceniu aktualizacji, a nie globalnym paraliżu.

Warto również odświeżyć wiedzę o wzorcu grodziowym (Bulkhead Pattern). Izolacja procesów i pul wątków sprawia, że awaria jednego komponentu (w tym przypadku modułu zarządzania botami) nie topi całego statku.

Incydent z listopada 2025 roku to dowód na to, że w skali makro małe błędy nie istnieją. Istnieją tylko błędy, które jeszcze nie znalazły swojego wyzwalacza. Dla branży IT to sygnał, by przestać polegać wyłącznie na testach funkcjonalnych, a zacząć projektować systemy, które są gotowe na to, co „niemożliwe”. Prawdziwa odporność to nie brak błędów, ale umiejętność przetrwania ich aktywacji.