Rozwój sztucznej inteligencji to nie tylko postęp obliczeniowy. Trening modeli językowych i generatywnych wymaga tysięcy akceleratorów GPU/TPU, które pożerają dziesiątki megawatów mocy. W rezultacie rośnie zużycie energii elektrycznej w centrach danych – w Irlandii w 2024 r. centra danych skonsumowały aż 22% całej energii w kraju. Taki udział jest wyzwaniem dla dostawców energii i operatorów DC, którzy muszą zmieścić rosnący popyt w coraz droższych cennikach, równocześnie redukując emisje CO₂.

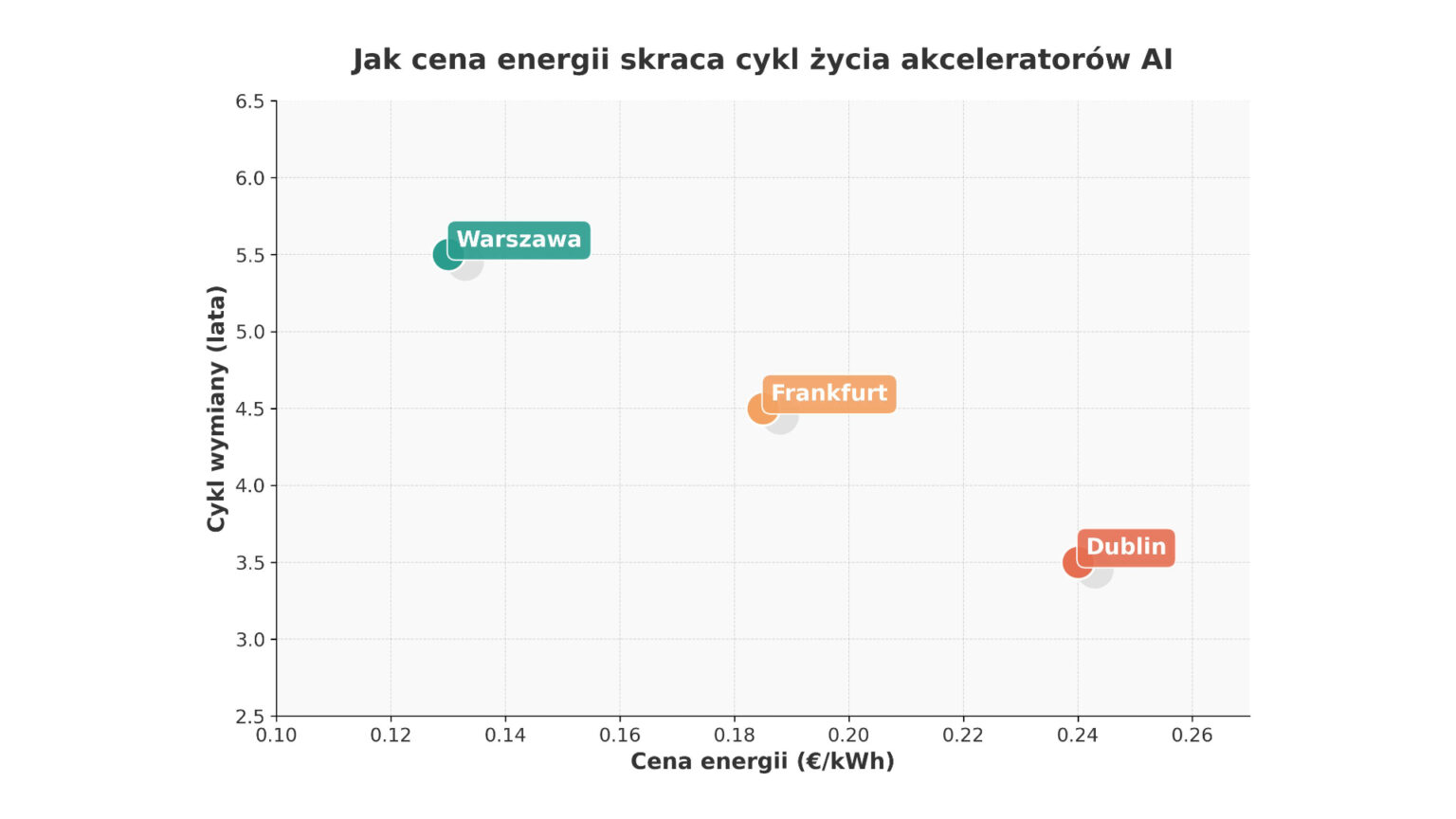

Niniejszy artykuł porównuje ceny energii w trzech kluczowych europejskich hubach danych – Frankfurcie, Dublinie i Warszawie – z efektywnością energetyczną kolejnych generacji akceleratorów AI. Na tej podstawie analizujemy, jak koszty operacyjne i postęp technologiczny skracają lub wydłużają cykl życia sprzętu AI.

Ceny energii w różnych hubach

Frankfurt: wysokie ceny i wymagania proekologiczne

Frankfurt to drugi pod względem wielkości rynek centrów danych w Europie. Niemcy mają jedne z najwyższych cen energii przemysłowej; w 2024 r. firmy płaciły średnio 16,77 centów za kWh, a w styczniu 2025 r. stawka wzrosła do 17,99 ct/kWh. Dla przedsiębiorstw objętych ulgami (stałe zużycie) koszt wynosił 10,47 ct/kWh. Na te opłaty składa się 29% podatków i opłat oraz 27% opłat sieciowych.

Silny nacisk na energię z OZE i odzysk ciepła obliguje operatorów centrów danych do inwestycji w zrównoważone rozwiązania. Wysokie koszty energii motywują do szybkiego wdrażania bardziej wydajnych układów, aby zmniejszyć zużycie na teraflops.

Dublin: najdroższy prąd w UE i ograniczenia podażowe

W Irlandii ceny energii dla odbiorców przemysłowych należą do najwyższych w Europie – ok. 26 euro za 100 kWh w pierwszej połowie 2024 r. Raport SEAI pokazuje, że w 2024 r. średnia ważona cena dla biznesu wynosiła 22,8 centa za kWh, a duzi odbiorcy płacili 16,3 c/kWh. Wysokie stawki są potęgowane przez brak mocy – centra danych w Dublinie zużywają 22% krajowej energii, a EirGrid przewiduje wzrost do 30% do 2030 roku. Z tego powodu nowe przyłączenia są zatwierdzane tylko w wyjątkowych przypadkach, więc operatorzy muszą maksymalizować efektywność istniejącej infrastruktury.

Warszawa: niższe ceny, ale rosnący rynek

Polska wyróżnia się niższymi cenami – około 0,13 euro za kWh w 2024 r. Według GlobalPetrolPrices w marcu 2025 r. biznes płacił średnio 1,023 PLN/kWh (0,28 USD), co wciąż jest niższe niż w Niemczech czy Irlandii. Choć niższe koszty energii pozwalają na dłuższy cykl amortyzacji, rosnąca konkurencja i popyt na usługi chmurowe zachęcają do inwestowania w nowy sprzęt, aby zwiększyć gęstość obliczeniową.

Generacje akceleratorów: wydajność na wat

GPU – od Volty do Blackwella

Nvidia V100 (Volta) wprowadziła w 2017 r. technikę tensor cores, ale jej TDP rzędu 300 W i mniejszy współczynnik TFLOPS/W są już nieopłacalne. W 2020 r. na rynku pojawił się A100 (Ampere) o TDP 400 W, który podwoił wydajność na wat, osiągając nawet 10 TFLOPS/W. Kolejny przełom to H100 z 2022 r., wykorzystujący architekturę Hopper: układ o mocy 700 W dostarcza 20 TFLOPS/W i około trzykrotnie więcej pracy od A100 na wat.

W 2024 r. Nvidia ogłosiła H200 – chip z TDP 700 W, wyposażony w pamięć HBM3e o przepustowości 4,8 TB/s. To zwiększyło wydajność inference o 30–45% przy tym samym poborze mocy. System DGX H200 ośmioma takimi GPU zużywa 5,6 kW, lecz potrafi wykonać dwa razy więcej pracy per wat w porównaniu z poprzednikiem.

W 2025 r. ma zadebiutować B200 (Blackwell), o TDP 1000 W i trzykrotnie wyższej mocy obliczeniowej od H100. Choć pobór mocy rośnie, współczynnik TFLOPS/W wciąż się poprawia, przesuwając granicę gęstości obliczeniowej.

TPU – alternatywa z lepszą efektywnością energetyczną

Google rozwija Tensor Processing Units, dedykowane akceleratory AI. TPU v4 oferuje 1,2–1,7 razy lepszą wydajność na wat niż A100, a generalnie TPUs są 2–3 razy bardziej energooszczędne niż GPU. Nadchodzące generacje, takie jak v6 „Trillium” i v7 „Ironwood”, koncentrują się na maksymalizacji gęstości obliczeń przy redukcji zużycia energii.

Cykl życia sprzętu – elastyczność zamiast sztywnej amortyzacji

W tradycyjnych centrach danych sprzęt był wymieniany co 5–7 lat. Jednak badania nad dekarbonizacją wskazują, że w środowiskach AI ekonomicznie opłacalne są cykle czteroletnie lub dłuższe, choć skrócenie cyklu może zmniejszyć emisje. Gdy nowa generacja GPU zapewnia kilkukrotnie wyższą wydajność energetyczną, wcześniejsze wycofanie starzejących się układów jest uzasadnione – oszczędności energii i redukcja kosztów emisji przewyższają nakłady inwestycyjne. Wymiana co 4–5 lat może stać się normą w regionach o wysokich cenach energii.

Jak cena prądu wpływa na decyzje o modernizacji?

Dublin – potrzeba gęstości obliczeniowej

Przy cenach 22–26 centów za kWh i ograniczonej mocy sieciowej, irlandzkie centra danych są zmuszone do maksymalizacji wydajności. Inwestycja w H100 lub H200 zwraca się szybciej dzięki dwukrotnie wyższej wydajności na wat. Zamiana starych A100 na H100/H200 skraca cykl amortyzacji do 3–4 lat, ponieważ oszczędności energii i niższe koszty emisji przewyższają wydatki kapitałowe. Wprowadzenie jeszcze bardziej energooszczędnych układów (B200, TPU v6) może dodatkowo przyspieszyć modernizację.

Frankfurt – kompromis między kosztami a inwestycją

Niemieckie ceny energii (17–20 ct/kWh) są niższe niż w Irlandii, ale wciąż motywują do optymalizacji. Firmy chętnie wymieniają sprzęt co 4–5 lat, zwłaszcza gdy różnica między generacjami jest duża. Jednocześnie większe systemy mogą korzystać z ulg i kontraktów długoterminowych, co zmniejsza presję na natychmiastową wymianę. Regulacje zobowiązujące do korzystania z OZE i odzysku ciepła zachęcają do wyboru energooszczędnych platform.

Warszawa – dłuższy oddech, ale rosnące ambicje

Niższy koszt energii (ok. 13 ct/kWh) pozwala polskim operatorom wydłużyć cykl życia sprzętu. Wymiana V100 na A100 lub H100 wciąż przynosi oszczędności, ale nie są one aż tak spektakularne jak w Irlandii. Rosnący popyt na usługi AI, rozwój biur R&D w Polsce i konkurencja międzynarodowych graczy mogą jednak skrócić cykle wymiany do 4–5 lat, zwłaszcza gdy na rynku pojawią się B200 i energooszczędne TPUs.

Trendy przyszłości: pamięć HBM3e, architektura Blackwell i TPU Trillium

Wydajność akceleratorów nie rośnie tylko dzięki większej liczbie rdzeni. Nowe układy, takie jak H200, zwiększają przepustowość pamięci do 4,8 TB/s poprzez HBM3e. Kolejny skok to Blackwell B200 o TDP 1000 W, który wykorzystuje szersze magistrale i usprawnione rdzenie Transformer Engine. Z kolei Google rozwija TPU v6 „Trillium” i v7 „Ironwood”, które mają poprawić energooszczędność i gęstość obliczeń.

Wydajność na wat staje się najważniejszym parametrem, bo ekonomiczne i regulacyjne naciski zmuszają operatorów do redukcji emisji. Wysokie ceny energii w Europie dodatkowo potęgują ten trend.

Różnice w cenach energii w Europie determinują strategie modernizacji infrastruktury AI. Irlandia i Niemcy, z najwyższymi stawkami, skracają cykle życia sprzętu, aby ograniczyć koszty operacyjne. Polska, korzystając z niższych cen, może sobie pozwolić na dłuższe korzystanie z istniejących układów, choć rosnący popyt i konkurencja także tam przyspieszą zmiany.

Postęp technologiczny – od GPU V100, przez A100 i H100, po H200 i nadchodzący B200 – sprawia, że współczynnik TFLOPS/W rośnie wykładniczo. Alternatywne akceleratory TPU wykazują jeszcze większą energooszczędność, co może w przyszłości zmienić dominację GPU. Dlatego decyzje o wymianie sprzętu nie mogą być sztywne; muszą uwzględniać nie tylko koszt nowego hardware’u, ale też ceny energii, emisje CO₂ i wymagania klientów. Megawaty i teraflopsy będą coraz mocniej splatać się w strategiach operatorów centrów danych w nadchodzącej dekadzie.