Branża technologiczna, po dwóch latach fascynacji Generative AI, wchodzi w etap „sprawdzam”. Entuzjazm zderza się z twardą rzeczywistością. Dane statystyczne, wskazujące na niewielki poziom adopcji AI w wielu gospodarkach, sprowadzają nas na ziemię.

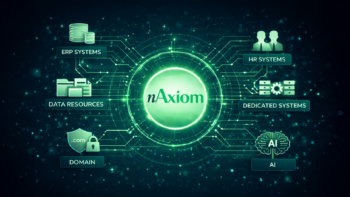

Tegoroczne Dell Technologies Forum w Warszawie było tego dobrym przykładem. Jak trafnie podsumował to Dariusz Piotrowski, obecnie kluczowy dogmat brzmi: „AI podąża za danymi, nie odwrotnie”. To nie algorytmy są już wąskim gardłem. Prawdziwym wyzwaniem dla biznesu jest dostęp do czystych, bezpiecznych i dobrze zorganizowanych danych. Dyskusja definitywnie przeniosła się z laboratorium na zaplecze operacyjne.

AI podąża za danymi

Żyliśmy w przekonaniu, że kluczem do rewolucji jest doskonalszy algorytm. Ten mit właśnie upada. Wewnętrzne studia przypadków największych firm technologicznych pokazują jednak: wdrożenie wewnętrznego narzędzia AI to często nie problem samego modelu, ale miesiące żmudnej pracy nad… uporządkowaniem i zapewnieniem dostępu do rozproszonych danych.

Rodzi to natychmiastową konsekwencję: moc obliczeniowa musi przenieść się tam, gdzie dane powstają. Zamiast wysyłać terabajty informacji do centralnej chmury, AI musi zacząć działać „na brzegu” (Edge AI).

Najbardziej widocznym przejawem tego trendu są narodziny ery AI PC. Dzięki dedykowanym procesorom (NPU), komputery osobiste mają lokalnie radzić sobie z zadaniami AI. Nie jest to marketingowy chwyt, ale fundamentalna zmiana architektury. Chodzi o bezpieczeństwo i prywatność – kluczowe dane nie muszą już opuszczać biurka, by zostać przetworzone. Oczywiście, ta układanka nie zadziała bez twardych fundamentów. Skoro dane są tak krytyczne, zmienia się krajobraz cyberbezpieczeństwa. Celem ataku numer jeden nie są już systemy produkcyjne, ale backup. To dlatego koncepcje „cyfrowych bunkrów” (restore vault) – gwarantujących dostęp do „niezatrutych” danych – stają się absolutną podstawą każdej poważnej strategii AI.

Pragmatyzm kontra „Agent Washing”

Jak w tym rozgrzanym do czerwoności rynku odróżnić realną wartość od marketingowej iluzji? Po fali fascynacji „GenAI”, nowym „świętym Graalem” branży stają się „Agenci AI”. Musimy jednak uważać na zjawisko „Agent Washingu” – pakowania starych algorytmów w nowe, błyszczące pudełko z modną etykietą.

Biznes zaczyna rozumieć, że chaotyczne podejście „bottom-up” prowadzi donikąd. Jak szczerze przyznał Said Akar z Dell Technologies, firma na początku zebrała „1800 przypadków użycia” AI, co mogło stać się prostą drogą do paraliżu. Dlatego strategię zmieniono na twarde „top-down”: znalezienie realnego problemu biznesowego, zdefiniowanie mierzalnego zwrotu z inwestycji (ROI) i dopiero wtedy dobranie narzędzi.

Prowadzi to wprost do globalnego trendu: odchodzenia od pogoni za jednym, gigantycznym modelem ogólnym (AGI) na rzecz „Wąskiej AI” (Narrow AI). Trend ten łączy się z rosnącą potrzebą cyfrowej suwerenności. Państwa i kluczowe sektory (jak finanse czy administracja) nie mogą sobie pozwolić na uzależnienie od kilku globalnych dostawców. Stąd rosnący trend inwestycji w lokalne modele, które pozwalają na większą kontrolę.

Hype kontra halucynacje

Gdy opada kurz, okazuje się, że wielki wyścig technologiczny nie polega już tylko na tym, by modele wiedziały więcej. Chodzi o to, by… rzadziej zmyślały. Największym problemem technicznym i biznesowym pozostają halucynacje.

Dominującym i jedynym realnym modelem biznesowym staje się „human-in-the-loop”, czyli człowiek w centrum procesu. W branżach regulowanych nikt przy zdrowych zmysłach nie pozwoli maszynie samodzielnie „pociągnąć za wajchę”. Jak trafnie zauważyła Agnieszka Słomka-Gołębiowska z mBanku, instytucje finansowe działają w „biznesie zaufania”, a największym ryzykiem AI jest „stronniczość”, której nie można w pełni kontrolować w samym modelu.

Sztuczna inteligencja ma stać się potężnym współpracownikiem, który przejmie „niewdzięczne zadania”. Ale ostateczna, strategiczna decyzja należy do człowieka. Prawdziwa rewolucja jest pragmatyczna, dzieje się „na krawędzi” i ma w pracy pomagać, a nie ją zabierać.