Sztuczna inteligencja jeszcze kilka lat temu była futurystyczną wizją, a dziś stanowi kluczowy element cyfrowej transformacji. Jej rozwój i wdrożenia są w dużej mierze kształtowane przez największe firmy technologiczne – Google, Microsoft, Amazon, Meta czy Apple. To właśnie te korporacje posiadają zarówno kapitał, jak i infrastrukturę, aby trenować i rozwijać zaawansowane modele AI.

W ostatnich latach wyścig o dominację w dziedzinie AI nabrał tempa. Microsoft strategicznie inwestuje w OpenAI, a ostatnio inwestuje także we własny model, Google rozwija własne modele w ramach DeepMind i Gemini, a Amazon wzmacnia swoje usługi chmurowe o nowe narzędzia oparte na sztucznej inteligencji, w ostatnim czasie również dołączając do bezpośredniego wyścigu AI dzięki ogłoszeniu Amazon Nova. Z jednej strony oznacza to dynamiczny postęp technologiczny, z drugiej – rodzi pytania o monopolizację tej kluczowej technologii. Czy mniejsze firmy i startupy mają jeszcze szansę na konkurowanie w tej dziedzinie? Jakie są konsekwencje takiego układu sił dla innowacji i dostępności AI?

Status quo: kto rządzi rynkiem AI?

Obecny krajobraz sztucznej inteligencji jest zdominowany przez kilka gigantycznych firm technologicznych, które nie tylko posiadają największe zasoby obliczeniowe, ale także inwestują miliardy dolarów w rozwój AI. Google, Microsoft, Amazon, Meta, Apple oraz Nvidia to główni gracze, którzy kontrolują zarówno rozwój modeli AI, jak i infrastrukturę potrzebną do ich działania.

Najwięksi gracze i ich strategie

- Microsoft & OpenAI – Microsoft zainwestował już ponad 13 miliardów dolarów w OpenAI i mocno integruje modele AI, takie jak GPT-4, z własnymi produktami (np. Copilot w systemie Windows i pakiecie Office). Ostatnie nieoficjalne doniesienia sugerują, że gigant z Redmond nie poprzestaje na zewnętrzych modelach AI i inwestuje we własne.

- Google & DeepMind – Google od lat rozwija własne modele AI, a jego jednostka badawcza DeepMind stoi za takimi osiągnięciami jak AlphaFold czy nowa seria modeli Gemini. Firma zintegrowała AI w swoich usługach, od wyszukiwarki po chmurę.

- Amazon – Jako lider w sektorze chmurowym, Amazon rozwija AI w ramach AWS, oferując własne modele AI, takie jak Bedrock oraz narzędzia do budowy chatbotów i systemów predykcyjnych. Poza tym, w połowie lutego Amazon ogłosił własne modele AI – Amazon Nova.

- Meta (Facebook) – Meta skupia się na AI generatywnej oraz otwartoźródłowych modelach, jak Llama 2, które mają być alternatywą dla zamkniętych systemów.

- Apple – Choć Apple wydaje się mniej aktywne w publicznych dyskusjach o AI, to pracuje nad integracją tej technologii w ekosystemie iPhone’ów i Maców, inwestując w rozwój AI-on-device.

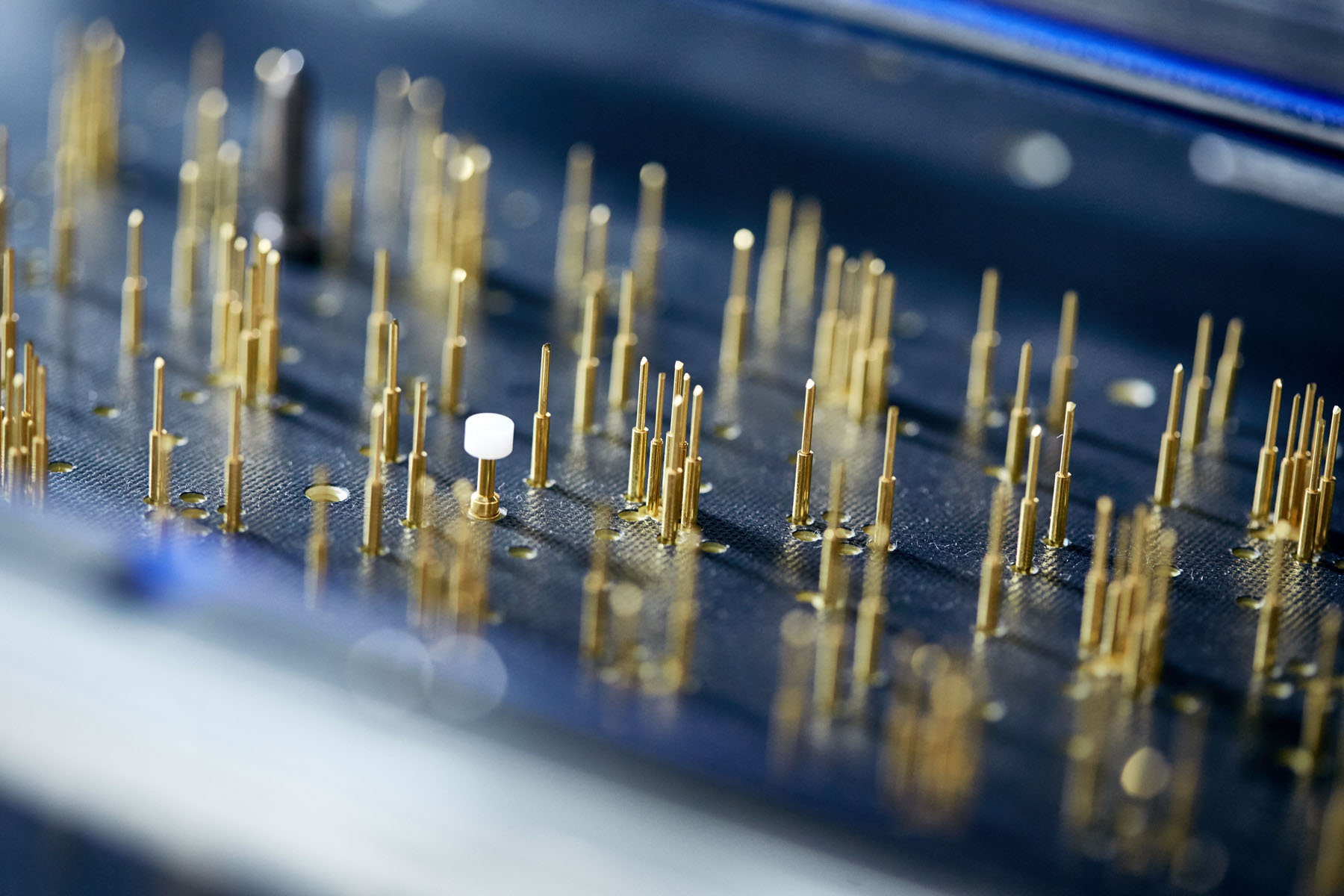

- Nvidia – Nie rozwija własnych modeli, ale ma największy udział w rynku sprzętu dla AI. Jej karty graficzne (GPU) są podstawą dla treningu i działania najnowocześniejszych modeli AI.

Dominacja Big Tech w AI wynika nie tylko z doświadczenia i zespołów badawczych, ale przede wszystkim z dostępu do gigantycznych zasobów obliczeniowych. Trening zaawansowanego modelu językowego, takiego jak GPT-4 czy Gemini, wymaga tysięcy układów GPU, co sprawia, że tylko najwięksi gracze mogą sobie na to pozwolić.

Ponadto, wiele startupów AI jest uzależnionych od infrastruktury dostarczanej przez te firmy – od chmury (AWS, Google Cloud, Azure), przez API do modeli AI, aż po narzędzia programistyczne.

AI jako nowy monopol – czy grozi nam dominacja kilku firm?

Coraz częściej pojawiają się obawy, że zamiast szeroko dostępnej technologii, AI staje się domeną kilku gigantycznych firm. Microsoft, Google, Amazon, Meta i Nvidia inwestują miliardy dolarów w rozwój AI i kontrolują kluczowe zasoby: modele, dane i infrastrukturę obliczeniową. Czy grozi nam sytuacja, w której dostęp do najbardziej zaawansowanych systemów AI będzie ściśle kontrolowany przez nielicznych?

Jednym z największych wyzwań jest to, że startupy i mniejsze firmy są w dużej mierze zależne od infrastruktury dostarczanej przez gigantów. Budowa własnego modelu AI od podstaw wymaga nie tylko ogromnej mocy obliczeniowej, ale także dostępu do wysokiej jakości danych, co często jest poza zasięgiem mniejszych graczy. W rezultacie wiele firm korzysta z gotowych modeli dostarczanych przez OpenAI (GPT-4), Google (Gemini) czy Meta (Llama), co jeszcze bardziej umacnia pozycję tych gigantów.

Jeśli rozwój sztucznej inteligencji zostanie scentralizowany w rękach kilku firm, mogą pojawić się poważne konsekwencje:

- Ograniczona konkurencja – mniejsze firmy będą miały utrudniony dostęp do zaawansowanych technologii.

- Wysokie koszty dostępu – AI może stać się usługą premium, dostępną tylko dla tych, którzy zapłacą.

- Brak przejrzystości – zamknięte modele AI nie ujawniają, jak są trenowane, co budzi pytania o ich obiektywność i etykę.

- Potencjalna cenzura i kontrola narracji – AI wykorzystywana w wyszukiwarkach, mediach społecznościowych i generowaniu treści może wpływać na sposób, w jaki konsumujemy informacje.

Przykładem globalnych napięć jest DeepSeek, chiński projekt AI, który rozwija modele językowe jako alternatywę dla amerykańskich gigantów. DeepSeek AI to open-source’owy model LLM (Large Language Model), który ma uniezależnić Chiny od OpenAI i Google. Rząd w Pekinie od lat inwestuje w sztuczną inteligencję, widząc ją jako kluczowy element przyszłej konkurencyjności. To oznacza, że walka o dominację nad AI nie ogranicza się tylko do korporacji – staje się częścią globalnej rywalizacji gospodarczej.

Rośnie ruch na rzecz otwartej i zdecentralizowanej sztucznej inteligencji. Inicjatywy takie jak Hugging Face, Stability AI czy Mistral AI rozwijają open-source’owe modele, które mogą być używane bez ograniczeń narzuconych przez Big Tech. Choć modele open-source mają wiele zalet (dostępność, przejrzystość), ich rozwój wciąż wymaga ogromnych zasobów. Kluczowym pytaniem pozostaje, czy rządy i firmy będą wspierać otwarte AI, czy pozwolą na dalszą koncentrację technologii w rękach kilku korporacji.

Przyszłość AI jeszcze nie jest przesądzona. To, czy stanie się otwartym narzędziem dla wszystkich, czy zamkniętym systemem kontrolowanym przez kilka firm, zależy od decyzji podejmowanych dziś.

Open-source kontra zamknięte modele – gdzie leży przyszłość?

Podział na otwarte i zamknięte modele AI nie jest tylko kwestią techniczną – to fundamentalna różnica w podejściu do przyszłości sztucznej inteligencji. Z jednej strony mamy firmy, które traktują AI jako zasób strategiczny, kontrolowany i monetyzowany, z drugiej rosnący ruch open-source, stawiający na dostępność i transparentność. Ta rywalizacja będzie miała kluczowy wpływ na to, kto w przyszłości będzie mógł korzystać z zaawansowanej sztucznej inteligencji i na jakich warunkach.

Open-source AI zdobywa coraz większą popularność, bo oferuje coś, czego brakuje zamkniętym modelom – elastyczność i niezależność. Deweloperzy mogą dostosowywać modele do własnych potrzeb, bez ograniczeń wynikających z regulaminów OpenAI, Google czy Anthropic. To szczególnie ważne dla sektora naukowego, startupów oraz firm poszukujących tańszych alternatyw.

Jednak wzrost popularności otwartego AI może zagrozić modelowi biznesowemu Big Tech. Jeśli organizacje będą mogły samodzielnie uruchamiać własne modele, bez potrzeby płacenia za API OpenAI czy Google Cloud, oznacza to mniejsze zyski dla tych firm. W odpowiedzi korporacje próbują balansować między otwartością a kontrolą – Meta udostępniła Llama 2, ale wciąż wymaga zgody na komercyjne użycie, a Google eksperymentuje z częściowo otwartymi modelami.

Geopolityczny wymiar otwartego AI

Sztuczna inteligencja staje się też elementem globalnej rywalizacji. Chiny rozwijają alternatywne modele open-source, jak DeepSeek AI, które mają uniezależnić kraj od amerykańskich technologii. DeepSeek jest częścią szerszej strategii Pekinu, zakładającej rozwój suwerennego ekosystemu AI – odpornego na sankcje i kontrolę Zachodu.

To pokazuje, że otwartość AI to nie tylko kwestia wolności technologicznej, ale też geopolityki i bezpieczeństwa narodowego. Europa również szuka niezależności, wspierając inicjatywy takie jak Mistral AI, ale wciąż jest w tyle za USA i Chinami pod względem inwestycji.

Nie ma jednoznacznej odpowiedzi, która ścieżka zwycięży. AI rozwija się dynamicznie, na wielu płaszczyznach, pod wpływem różnych czynników, przez co przewidzenie dalszego rozwoju nie jest łatwe. Pewnym jest natomiast, że ktokolwiek może, stara się być jak najbliżej AI, inwestować w nią, rozwijać, ingerować w rozwój, ponieważ w tym momencie jest ona czarnym koniem rozwoju technologicznego. W zależności od ruchów, jakie podejmą firmy tworzące AI, a także od roszad geopolitycznych oraz poziomu regulacji, jakie będą nakładane na AI, możliwe wydają się być trzy scenariusze: wzmocnienie Big Tech – jeśli zamknięte modele okażą się bardziej zaawansowane i kosztowne w utrzymaniu niż ich otwarte odpowiedniki; ekspansja open-source – jeśli rządy i instytucje akademickie zaczną wspierać otwarte AI jako przeciwwagę dla monopolu korporacji lub model hybrydowy – gdzie otwarte modele będą szeroko stosowane, ale najpotężniejsze systemy pozostaną zamknięte.

Regulacje i polityka – czy rządy mogą ograniczyć wpływ Big Tech na AI?

Rządy starają się regulować rozwój sztucznej inteligencji, aby ograniczyć monopol Big Tech i zwiększyć kontrolę nad jej wpływem na społeczeństwo. Unia Europejska przyjęła AI Act, który klasyfikuje modele AI według ryzyka i nakłada na firmy obowiązki dotyczące przejrzystości. USA podchodzą ostrożniej, prowadząc rozmowy z technologicznymi gigantami i koncentrując się na rywalizacji z Chinami. Chiny natomiast już teraz wymagają certyfikacji modeli AI i rozwijają własne alternatywy, takie jak DeepSeek AI, by uniezależnić się od amerykańskich firm.

Choć regulacje mogą zwiększyć nadzór nad AI, mogą też nieoczekiwanie umocnić dominację Big Tech, bo to właśnie największe firmy mają środki na dostosowanie się do nowych wymogów. Aby rzeczywiście zwiększyć konkurencję, konieczne jest wspieranie alternatywnych rozwiązań, takich jak modele open-source i inicjatywy krajowe. Polska, choć nie jest globalnym liderem AI, również rozwija własne technologie, czego przykładem jest PLLuM (Polish Large Language Model), czyli pierwszy duży model językowy stworzony z myślą o języku polskim.

Przyszłość regulacji AI będzie balansowaniem między kontrolą a innowacją. Zbyt restrykcyjne przepisy mogą spowolnić rozwój technologii, podczas gdy ich brak grozi dominacją kilku korporacji kształtujących AI na własnych zasadach. Wspieranie narodowych inicjatyw, takich jak PLLuM, oraz open-source’owych modeli może stać się kluczowym narzędziem w budowaniu bardziej zdecentralizowanego ekosystemu sztucznej inteligencji.

Z jednej strony widzimy dynamiczny postęp i integrację AI w codziennym życiu, z drugiej – rosnące obawy o monopolizację i ograniczoną dostępność najpotężniejszych systemów dla mniejszych firm czy niezależnych badaczy.

Alternatywą dla dominacji Big Tech są modele open-source oraz inicjatywy narodowe, takie jak DeepSeek AI w Chinach czy PLLuM w Polsce. Choć otwarte modele oferują większą przejrzystość i dostępność, ich rozwój jest trudniejszy z powodu ograniczeń sprzętowych i finansowych. Rządy na całym świecie starają się regulować AI, ale ich działania, jak europejski AI Act, mogą paradoksalnie umocnić pozycję największych graczy, jeśli nie zostaną połączone ze wsparciem dla mniejszych podmiotów i inicjatyw open-source.

Przyszłość sztucznej inteligencji będzie zależała od tego, jak uda się wypracować równowagę między kontrolą a innowacją. Jeśli regulacje i otwarte technologie zostaną odpowiednio rozwinięte, AI może stać się narzędziem dostępnym dla wszystkich, a nie tylko dla kilku globalnych firm.