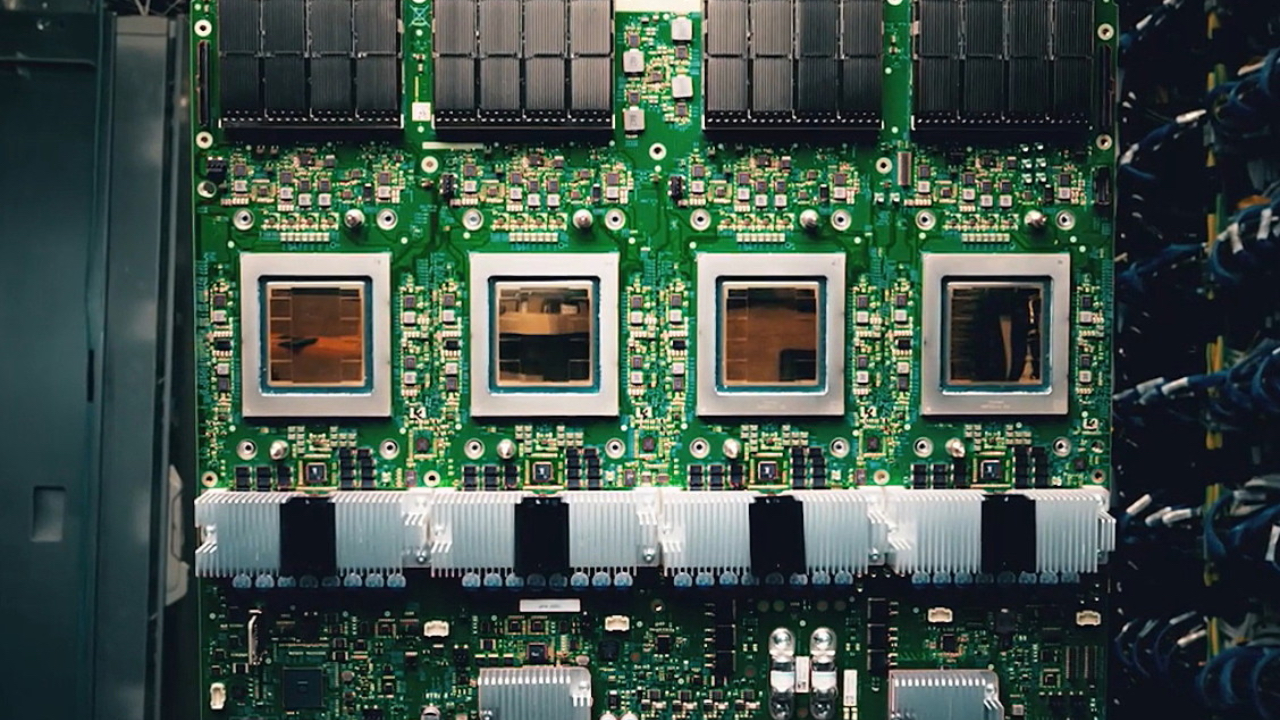

Podczas tegorocznego Google Cloud Next gigant z Mountain View zaprezentował Ironwood – najnowszy, samodzielnie zaprojektowany chip z rodziny TPU (Tensor Processing Unit), zaprojektowany z myślą o wnioskowaniu AI w centrach danych. To już siódma generacja tych układów i kolejny dowód na to, że największe firmy chmurowe nie chcą już tylko optymalizować cudzego sprzętu – chcą mieć własny.

TPU wraca do gry – i to z przytupem

Ironwood to pierwszy tak wyraźny sygnał od Google, że chipy dla sztucznej inteligencji nie muszą być synonimem produktów Nvidii. Nowy układ został zoptymalizowany wyłącznie pod kątem wnioskowania, co odróżnia go od wcześniejszych TPU, które często były projektowane uniwersalnie – z myślą o treningu i inferencji.

Specyfikacja mówi sama za siebie: 192 GB pamięci HBM, sześciokrotnie więcej niż w poprzedniku Trillium, oraz niemal dwukrotnie wyższa przepustowość – 7,2 TB/s. To parametry, które pozwalają nie tylko na uruchamianie dużych modeli LLM, ale też na błyskawiczną reakcję systemów rekomendacyjnych czy silników predykcyjnych w czasie rzeczywistym.

Warto zauważyć także poprawę efektywności energetycznej: 29,3 flopów na wat – to więcej niż dwukrotna poprawa względem Trillium (14,6). W czasach, gdy każdy wat w serwerowni jest liczony, to przewaga trudna do przecenienia.

Chmurowy hardware jako nowy wyróżnik

Ironwood nie trafi na półki sklepowe. Podobnie jak poprzednie TPU, chip będzie dostępny wyłącznie w Google Cloud, gdzie użytkownicy mogą korzystać z dwóch rozmiarów klastrów: od 256-chipowych jednostek HPC po tzw. „pody” złożone z 9216 chipów, osiągające według Google aż 42,5 eksaflopsa w FP8. W teorii – szybciej niż superkomputer El Capitan, choć realnie porównania te budzą wątpliwości ze względu na różnice w architekturze i zastosowaniach.

Ale nie o benchmarki tu chodzi. Ironwood to przede wszystkim argument strategiczny: Google dołącza do AWS i Microsoftu w wyścigu na własne układy krzemowe, próbując zredukować zależność od Nvidii – firmy, której GPU są dziś drogie, trudno dostępne i… często za uniwersalne.

AWS już od lat rozwija linie Trainium i Inferentia, Microsoft pracuje nad chipami Maia, a teraz Google pokazuje, że może nie tylko projektować hardware, ale też dostarczać go w skali, która ma znaczenie dla największych klientów.

Ironwood jako narzędzie i jako ubezpieczenie

Warto spojrzeć na Ironwood nie tylko jak na chip, ale jak na strategiczny asset. Własna architektura to większa kontrola nad kosztami, dostępnością, optymalizacją software’u i – co coraz ważniejsze – śladem węglowym. To także sposób na budowanie unikalnej oferty w chmurze, z wyraźnie odróżniającym się zapleczem technologicznym.

Nieprzypadkowo w Ironwood znalazł się dedykowany akcelerator SparseCore, zoptymalizowany pod klasyczne zadania AI, takie jak systemy rekomendacji. W połączeniu z modelem dostępnym wyłącznie w chmurze, Google zyskuje silny atut w rozmowach z firmami z branż takich jak e-commerce, fintech czy media.

Nowa normalność w AI

Ironwood wpisuje się w szerszy trend: chmura staje się nie tylko platformą, ale też producentem hardware’u. Klienci nie chcą już tylko skalowalnych zasobów – chcą zoptymalizowanych rozwiązań, które pozwolą uruchomić AI szybciej, taniej i bardziej niezawodnie. Dla dostawców chmurowych oznacza to jedno: własny chip przestaje być ciekawostką, a staje się koniecznością.

Google zrobiło kolejny krok. Teraz pytanie brzmi: czy klienci będą gotowi na większe zaufanie do zamkniętych, firmowych ekosystemów AI? Jeśli Ironwood rzeczywiście będzie tak wydajny, jak twierdzi Google – odpowiedź może być twierdząca.