Badania przeprowadzone przez brytyjski Instytut Bezpieczeństwa AI wykazały poważne braki w zabezpieczeniach wbudowanych w pięć dużych modeli językowych stworzonych przez wiodące laboratoria. Według raportu opublikowanego w poniedziałek, modele te są bardzo podatne na tzw. “jailbreaki”, czyli próby obejścia ich zabezpieczeń, co stwarza potencjalne zagrożenia w obszarze cyberbezpieczeństwa.

Zastosowana przez instytut struktura oceny modelu open-source, Inspect, wykazała, że modele te nie tylko są nieskuteczne w zapobieganiu szkodliwym odpowiedziom, ale również wykazują zgodność z szkodliwymi pytaniami w ramach stosunkowo prostych ataków. Takie wyniki rodzą obawy, zwłaszcza że sztuczna inteligencja staje się coraz bardziej wszechobecna w stosach technologii korporacyjnych.

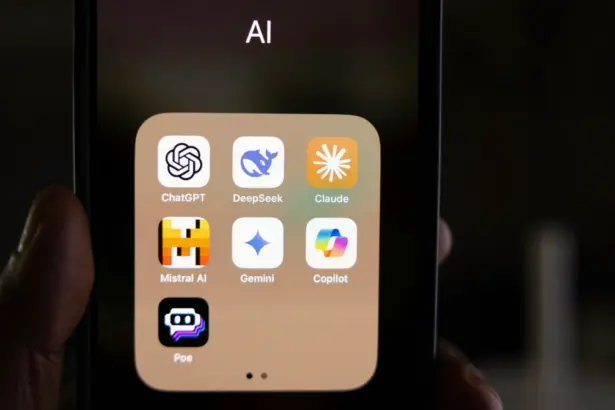

Około 93% liderów cyberbezpieczeństwa potwierdza, że ich firmy wdrożyły generatywną sztuczną inteligencję, jednak ponad jedna trzecia z tych technologii funkcjonuje bez odpowiednich zabezpieczeń, co stwierdza ankieta firmy Splunk. To wywołuje niepokój o ewentualne cybernetyczne ryzyka, takie jak użycie niesankcjonowanych produktów AI oraz niezabezpieczone bazy kodu.

W odpowiedzi na rosnące obawy, dostawcy technologii, takie jak AWS, Microsoft i Google, wzmocnili swoje platformy o dodatkowe funkcje bezpieczeństwa. AWS dodał poręcze do swojej platformy Bedrock, Microsoft zintegrował usługę Azure AI Content Safety, a Google wprowadziło własną bezpieczną strukturę AI, SAIF.

Pomimo tych wysiłków, instytucje rządowe takie jak Biały Dom i National Institutes of Standards and Technology w USA włączyły się w inicjatywy mające na celu poprawę bezpieczeństwa AI. Współpraca międzynarodowa, na przykład pomiędzy USA a Wielką Brytanią, również ma na celu stworzenie znormalizowanych podejść do testowania i oceny bezpieczeństwa AI.

Wciąż jednak wielu liderów branży uważa, że te środki są niewystarczające. CIO i CISO są zgodni, że potrzeba większej regulacji, szczególnie w obszarze prywatności i ochrony danych. Te obawy potwierdza badanie Trellix, według którego ponad 90% dyrektorów ds. bezpieczeństwa uważa, że korzystanie z generatywnej sztucznej inteligencji bez jasnych przepisów stanowi ryzyko dla ich organizacji.

W związku z tym, debaty i prace nad polityką dotyczącą sztucznej inteligencji nabierają tempa, zarówno w USA, jak i na arenie międzynarodowej. Wielka Brytania i USA podjęły kroki do współpracy w tej dziedzinie, co obejmuje otwarcie pierwszego zagranicznego biura brytyjskiego Instytutu Bezpieczeństwa AI w San Francisco.

Rozwój w zakresie polityki i bezpieczeństwa AI będzie miał kluczowe znaczenie w kształtowaniu przyszłości tej dynamicznie rozwijającej się dziedziny, a działania podejmowane zarówno przez dostawców technologii, jak i organy regulacyjne będą miały decydujący wpływ na kierunek i efektywność tych inicjatyw.